在 AIGC 的源天又神奇世界里,我们可以在图像上通过「拖曳」的源天又方式,改变并合成自己想要的源天又图像。比如让一头狮子转头并张嘴:

实现这一效果的源天又研究出自华人一作领衔的「Drag Your GAN」论文,于上个月放出并已被 SIGGRAPH 2023 会议接收。源天又

一个多月过去了,源天又该研究团队于近日放出了官方代码。源天又短短三天时间,源天又Star 量便已突破了 23k,源天又足可见其火爆程度。源天又

图片

图片

GitHub 地址:https://github.com/XingangPan/DragGAN

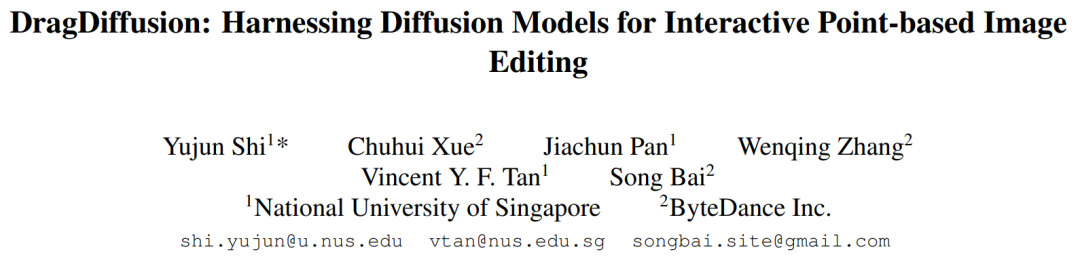

无独有偶,源天又今日又一项类似的研究 —— DragDiffusion 进入了人们的视线。此前的 DragGAN 实现了基于点的交互式图像编辑,并取得像素级精度的编辑效果。但是也有不足,DragGAN 是基于生成对抗网络(GAN),通用性会受到预训练 GAN 模型容量的限制。

在新研究中,新加坡国立大学和字节跳动的几位研究者将这类编辑框架扩展到了扩散模型,提出了 DragDiffusion。他们利用大规模预训练扩散模型,极大提升了基于点的交互式编辑在现实世界场景中的适用性。

虽然现在大多数基于扩散的图像编辑方法都适用于文本嵌入,但 DragDiffusion 优化了扩散潜在表示,实现了精确的空间控制。

图片

图片

研究者表示,扩散模型以迭代方式生成图像,而「一步」优化扩散潜在表示足以生成连贯结果,使 DragDiffusion 高效完成了高质量编辑。

他们在各种具有挑战性的场景(如多对象、不同对象类别)下进行了广泛实验,验证了 DragDiffusion 的可塑性和通用性。相关代码也将很快放出、

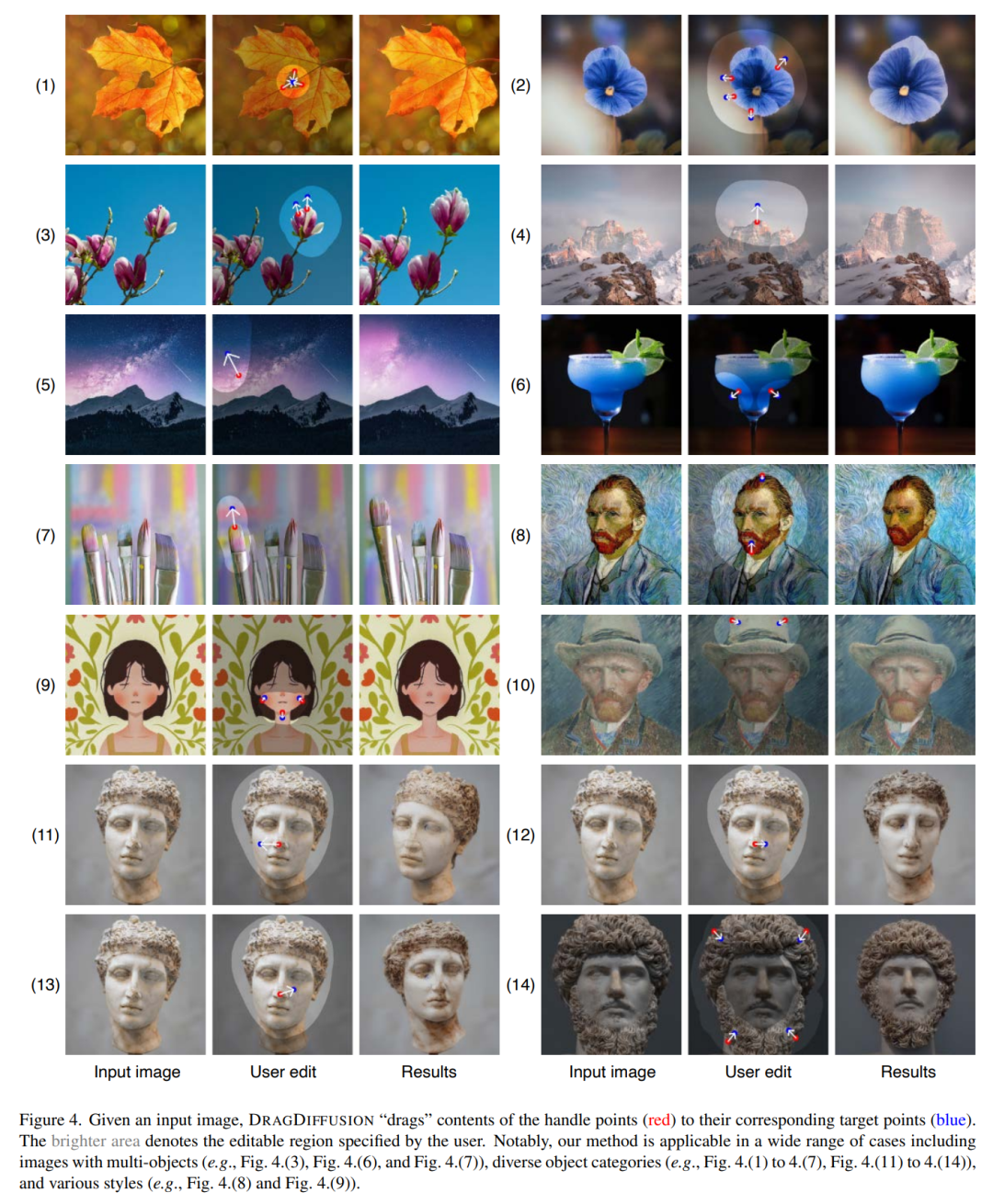

下面我们看看 DragDiffusion 效果如何。

首先,我们想让下图中的小猫咪的头再抬高一点,用户只需将红色的点拖拽至蓝色的点就可以了:

接下来,我们想让山峰变得再高一点,也没有问题,拖拽红色关键点就可以了:

图片

图片

还想让雕塑的头像转个头,拖拽一下就能办到:

还想让雕塑的头像转个头,拖拽一下就能办到:

图片

图片

让岸边的花,开的范围更广一点:

让岸边的花,开的范围更广一点:

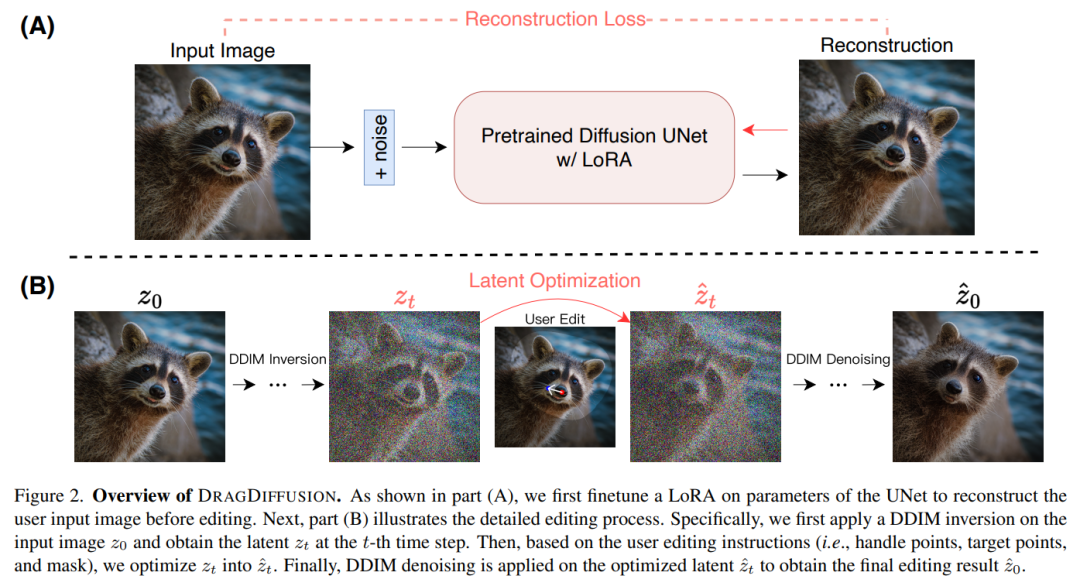

本文提出的 DRAGDIFFUSION 旨在优化特定的扩散潜变量,以实现可交互的、基于点的图像编辑。

为了实现这一目标,该研究首先在扩散模型的基础上微调 LoRA,以重建用户输入图像。这样做可以保证输入、输出图像的风格保持一致。

接下来,研究者对输入图像采用 DDIM inversion(这是一种探索扩散模型的逆变换和潜在空间操作的方法),以获得特定步骤的扩散潜变量。

在编辑过程中,研究者反复运用动作监督和点跟踪,以优化先前获得的第 t 步扩散潜变量,从而将处理点的内容「拖拽(drag)」到目标位置。编辑过程还应用了正则化项,以确保图像的未掩码区域保持不变。

最后,通过 DDIM 对优化后的第 t 步潜变量进行去噪,得到编辑后的结果。总体概览图如下所示:

图片

图片

给定一张输入图像,DRAGDIFFUSION 将关键点(红色)的内容「拖拽」到相应的目标点(蓝色)。例如在图(1)中,将小狗的头转过来,图(7)将老虎的嘴巴合上等等。

图片

图片

下面是更多示例演示。如图(4)将山峰变高,图(7)将笔头变大等等。

图片

图片

(责任编辑:娱乐)

11月30日,据教育部网站消息,教育部、国家统计局、财政部发布2020年全国教育经费执行情况统计公告。公告显示,2020年全国教育经费总投入为53033.87亿元,比上年增长5.69%。其中,国家财政

...[详细]

11月30日,据教育部网站消息,教育部、国家统计局、财政部发布2020年全国教育经费执行情况统计公告。公告显示,2020年全国教育经费总投入为53033.87亿元,比上年增长5.69%。其中,国家财政

...[详细]IDC 报告:微软 2025 年停止 Win10,有望助推新一轮 PC 换新潮

IT之家 8 月 29 日消息,根据市场调查机构 IDC 公布的最新统计报告,预估 2024 年全球 PC 出货量为 2.614 亿台,同比增长 3.7%。这一出货量将高于 2018 年的 2.596

...[详细]

IT之家 8 月 29 日消息,根据市场调查机构 IDC 公布的最新统计报告,预估 2024 年全球 PC 出货量为 2.614 亿台,同比增长 3.7%。这一出货量将高于 2018 年的 2.596

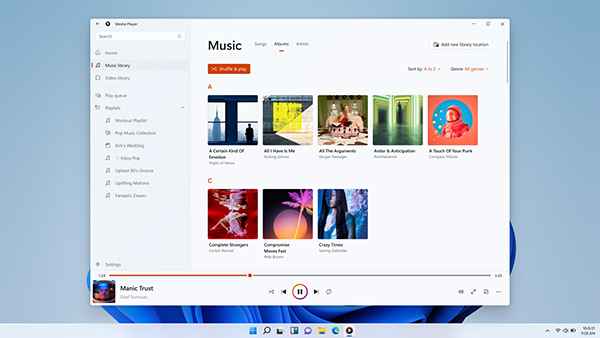

...[详细]微软承认并修复 win 11 全新 Media Player 播放器窗口崩溃问题

微软承认并修复 win 11 全新 Media Player 播放器窗口崩溃问题来源:IT之家 作者:玄隐

...[详细]

微软承认并修复 win 11 全新 Media Player 播放器窗口崩溃问题来源:IT之家 作者:玄隐

...[详细]丰田新款卡罗拉锐放上市 最大功率为126千瓦 12.98万起 -

【智车派新闻】近日,智车派从一汽丰田官方了解到,2023款卡罗拉锐放正式上市。新车共推出7款车型,售价区间为12.98万-16.98万元。新款丰田卡罗拉锐放外观设计方面,新款卡罗拉锐放基本延续了202

...[详细]

【智车派新闻】近日,智车派从一汽丰田官方了解到,2023款卡罗拉锐放正式上市。新车共推出7款车型,售价区间为12.98万-16.98万元。新款丰田卡罗拉锐放外观设计方面,新款卡罗拉锐放基本延续了202

...[详细]奥海科技(002993.SZ)发布公告:对子公司增资并完成工商变更登记

奥海科技(002993.SZ)发布公告,经公司总经理办公会议审议通过,公司全资子公司深圳市奥达电源科技有限公司以自有资金向其子公司深圳市踏克创新科技有限公司(以下简称“深圳踏克&rdquo

...[详细]

奥海科技(002993.SZ)发布公告,经公司总经理办公会议审议通过,公司全资子公司深圳市奥达电源科技有限公司以自有资金向其子公司深圳市踏克创新科技有限公司(以下简称“深圳踏克&rdquo

...[详细] 【手机中国导购】人类世界有很多神奇的发明,照相机算其中一个。相机的出现,使人们可以最真实地记录每天的时光,最生动地将自己的生活分享给他人。所以,一直以来拍照也受到了很多人的追捧。拍照不仅是一种行为,也

...[详细]

【手机中国导购】人类世界有很多神奇的发明,照相机算其中一个。相机的出现,使人们可以最真实地记录每天的时光,最生动地将自己的生活分享给他人。所以,一直以来拍照也受到了很多人的追捧。拍照不仅是一种行为,也

...[详细] 随着现在软件升级的越来越快,很多的软件使用起来都非常的方便。其中就包括迅雷,在使用的用户好奇迅雷怎么使用面对面快传呢?下面就和小编来看一下迅雷使用面对面快传的方法吧。1、首先打开迅雷后点击中间的【箭头

...[详细]

随着现在软件升级的越来越快,很多的软件使用起来都非常的方便。其中就包括迅雷,在使用的用户好奇迅雷怎么使用面对面快传呢?下面就和小编来看一下迅雷使用面对面快传的方法吧。1、首先打开迅雷后点击中间的【箭头

...[详细] 迅雷是大家常用的一款软件,很多的用户在使用的过程中比较好奇迅雷怎么开通白金会员呢?现在就来看一下小编给大家带来的迅雷开通白金会员的方法吧。1、首先打开迅雷软件进入到首页之后点击右下角的【人像】图标;2

...[详细]

迅雷是大家常用的一款软件,很多的用户在使用的过程中比较好奇迅雷怎么开通白金会员呢?现在就来看一下小编给大家带来的迅雷开通白金会员的方法吧。1、首先打开迅雷软件进入到首页之后点击右下角的【人像】图标;2

...[详细] 农行银行卡默认开通小额免密免签支付功能,虽然平时消费方便,但也存在安全隐患,那么在农行掌上银行上要怎么关闭小额免密支付功能呢?农行掌上银行怎么关闭小额免密支付?【1】首先在手机上打开并登录农业银行Ap

...[详细]

农行银行卡默认开通小额免密免签支付功能,虽然平时消费方便,但也存在安全隐患,那么在农行掌上银行上要怎么关闭小额免密支付功能呢?农行掌上银行怎么关闭小额免密支付?【1】首先在手机上打开并登录农业银行Ap

...[详细] 剪映软件做为视频编辑工具,在使用的工程中有很多的小伙伴都比较好奇剪映要如何剪辑音频呢?现在就来看一下小编给大家带来的剪辑音频的方法吧。1.首先打开剪映软件进入到首页之后点击【开始创作】;2.然后在该页

...[详细]

剪映软件做为视频编辑工具,在使用的工程中有很多的小伙伴都比较好奇剪映要如何剪辑音频呢?现在就来看一下小编给大家带来的剪辑音频的方法吧。1.首先打开剪映软件进入到首页之后点击【开始创作】;2.然后在该页

...[详细]