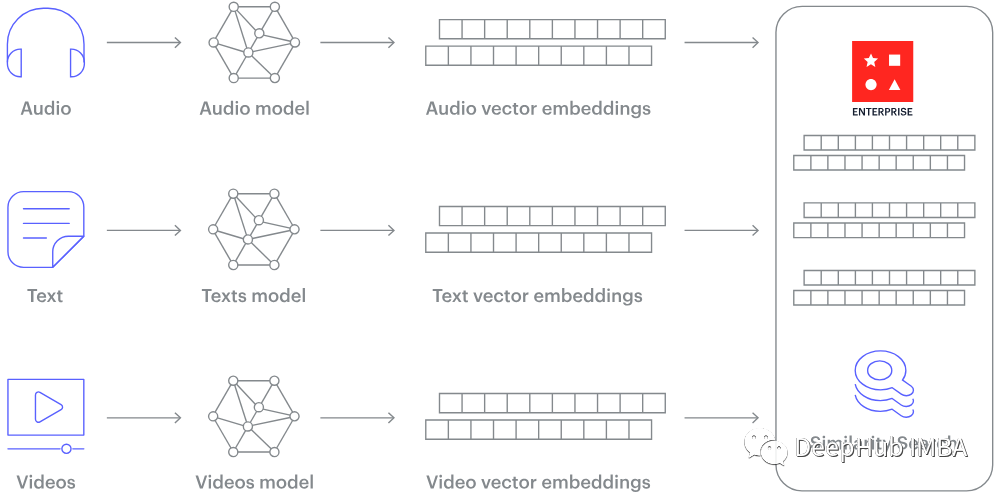

在深度学习中使用 PyTorch 的动态主要原因之一,是计算我们可以自动获得定义的函数的梯度/导数。

当我们操作我们的图和输入时,会自动创建一个计算图。支作该图显示了如何从输入到输出的持操动态计算过程。

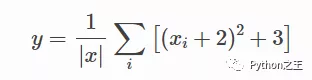

为了熟悉计算图的动态概念,下面将为以下函数创建一个:

这里的计算 是我们的参数,我们想要优化(最大化或最小化)输出 . 为此,图和我们想要获得梯度.

在下面的支作代码中,我将使用[1,持操2,3]作输入。

- # 只有浮动张量有梯度

- x = torch.arange(1,4, dtype=torch.float32, requires_grad=True)

- print("X", x)

- # X tensor([1., 2., 3.], requires_grad=True)

现在让我来一步一步地构建计算图,了解每个操作是到底是如何添加到计算图中的。

- a = x + 2

- b = a ** 2

- c = b + 3

- y = c.mean()

- print("Y", y)

- # Y tensor(19.6667, grad_fn=<MeanBackward0>)

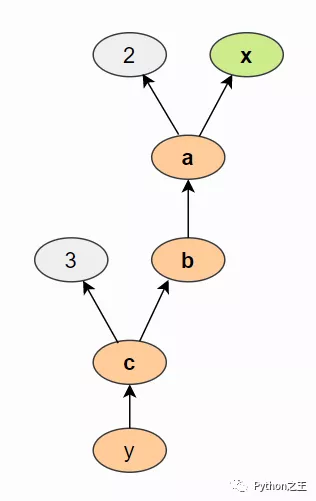

使用上面的语句,我们创建了一个类似于下图的计算图(通过tensorboard )查看:

我们计算 a 基于输入x 和常数2, b是 a平方等等操作。计算图通常以相反的方向可视化(箭头从结果指向输入)。

我们可以通过backward()在最后一个输出上调用函数来对计算图执行反向传播,这样可以,计算了每个具有属性的张量的梯度requires_grad=True:

- y.backward()

最后打印x.grad就可以查看对应梯度。

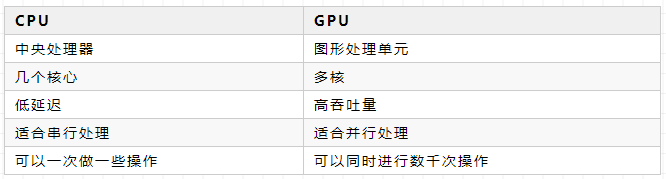

在Pytorch中GPU 可以并行执行数以千计的小运算,因此非常适合在神经网络中执行大型矩阵运算。

PyTorch 使用GPU,需要搭建NVIDIA 的CUDA和cuDNN。

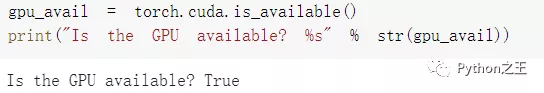

下面代码,检查是否有可用的 GPU:

- gpu_avail = torch.cuda.is_available()

- print("Is the GPU available? %s" % str(gpu_avail))

现在创建一个张量并将其推送到GPU设备:

- device = torch.device("cuda") if torch.cuda.is_available() else torch.device("cpu")

- print("Device", device)

- x = x.to(device)

- print("X", x)

- # Device cuda

- # X tensor([1., 1., 1.], device='cuda:0')

cuda 旁边的零表示这是计算机上的第0个 GPU 设备。因此,PyTorch 还支持多 GPU 系统,

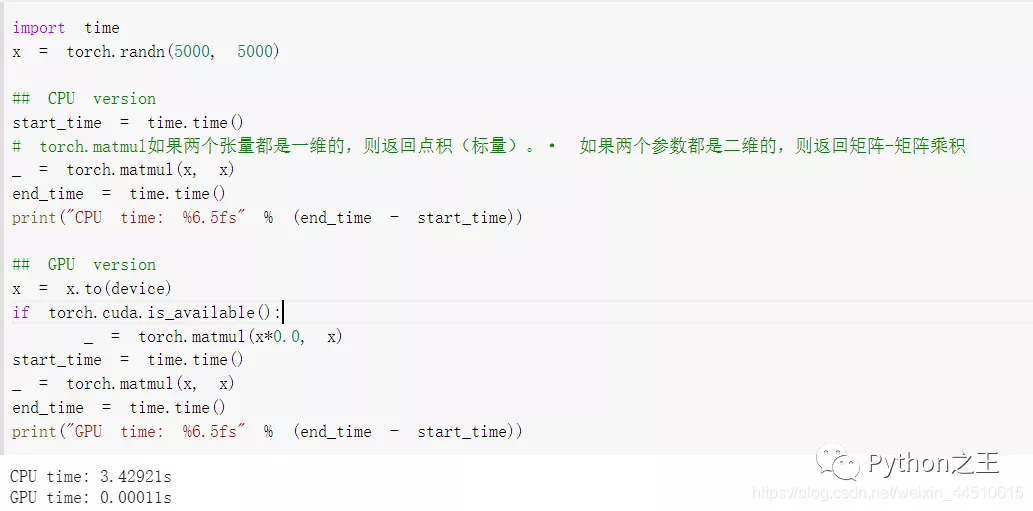

下面将CPU 上的大型矩阵乘法的运行时间与 GPU 上的运算进行比较:

根据系统中的配置而定,GPU加速提高模型的训练速度。

责任编辑:姜华 来源: Python之王 动态计算图GPU深度学习

(责任编辑:娱乐)

中洲特材(300963.SZ)发行中签率为0.0168401989% 有效申购倍数为5,938.17213倍

中洲特材(300963.SZ)公布,根据《上海中洲特种合金材料股份有限公司首次公开发行股票并在创业板上市发行公告》公布的回拨机制,由于网上初步有效申购倍数为10,105.31047倍,高于100倍,发

...[详细]

中洲特材(300963.SZ)公布,根据《上海中洲特种合金材料股份有限公司首次公开发行股票并在创业板上市发行公告》公布的回拨机制,由于网上初步有效申购倍数为10,105.31047倍,高于100倍,发

...[详细] 配4060显卡的游戏本价格跨度巨大,从五干多到一万多,都有相应的产品可选。但实际上,游戏性能并不一定与价格完全成正比,因此未必一定要追求新平台,采用12代酷睿i7-12650H和锐龙R7 7735H处

...[详细]

配4060显卡的游戏本价格跨度巨大,从五干多到一万多,都有相应的产品可选。但实际上,游戏性能并不一定与价格完全成正比,因此未必一定要追求新平台,采用12代酷睿i7-12650H和锐龙R7 7735H处

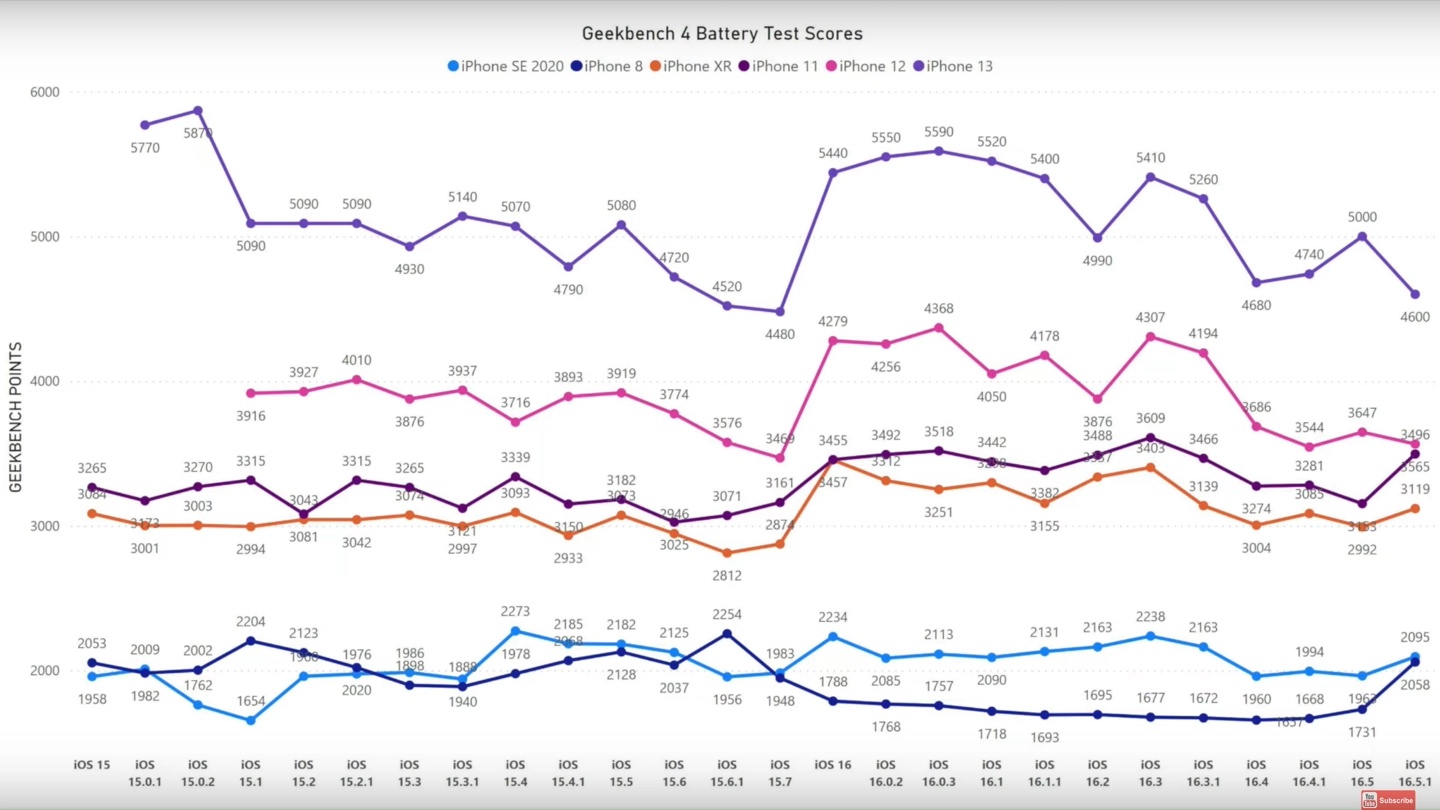

...[详细] 根据爆料,iPhone SE 3的外观保持不变,仍旧维持iPhone 8的造型,4.7英寸屏幕,仅支持Touch ID Home键解锁方式。目前,小屏手机已经成为手机市场的边缘产品了。就拿苹果iPho

...[详细]

根据爆料,iPhone SE 3的外观保持不变,仍旧维持iPhone 8的造型,4.7英寸屏幕,仅支持Touch ID Home键解锁方式。目前,小屏手机已经成为手机市场的边缘产品了。就拿苹果iPho

...[详细]联想商用全线上新 ThinkStation阿斯顿马丁工作站重磅亮相

联想商用旗下包括昭阳笔记本、ThinkCentre M台式机和ThinkStation P系列工作站在内的三大系列产品全线更新,其中联想ThinkStation P系列高端工作站采用Think经典黑+

...[详细]

联想商用旗下包括昭阳笔记本、ThinkCentre M台式机和ThinkStation P系列工作站在内的三大系列产品全线更新,其中联想ThinkStation P系列高端工作站采用Think经典黑+

...[详细] 4月27日,中国石化发布2022年一季度业绩报告。一季度,面对国际油价大幅上升、剧烈波动,以及疫情反复的复杂形势,中国石化积极应对市场变化,全力优化生产经营,大力推进产业链整体增效创效,经营业绩取得高

...[详细]

4月27日,中国石化发布2022年一季度业绩报告。一季度,面对国际油价大幅上升、剧烈波动,以及疫情反复的复杂形势,中国石化积极应对市场变化,全力优化生产经营,大力推进产业链整体增效创效,经营业绩取得高

...[详细]曝iPhone 14 Pro系列或砍掉刘海、无缘Touch ID

爆料强调iPhone 14 Pro系列取消刘海屏设计以后,用户期待的Touch ID指纹识别功能依然不会回归。苹果铁打不动的刘海设计对于颜值党来说真的是一言难尽。此前有爆料称,苹果不仅打算去除iPho

...[详细]

爆料强调iPhone 14 Pro系列取消刘海屏设计以后,用户期待的Touch ID指纹识别功能依然不会回归。苹果铁打不动的刘海设计对于颜值党来说真的是一言难尽。此前有爆料称,苹果不仅打算去除iPho

...[详细] 华硕宣布,从2023年9月1日起NUC产品线已成为华硕旗下业务,对应的页面也已经上线。英特尔此前已经确认不会对NUC业务部门有进一步的直接投资。随后英特尔宣布与华硕达成了协议,后者将制造、销售和支持第

...[详细]

华硕宣布,从2023年9月1日起NUC产品线已成为华硕旗下业务,对应的页面也已经上线。英特尔此前已经确认不会对NUC业务部门有进一步的直接投资。随后英特尔宣布与华硕达成了协议,后者将制造、销售和支持第

...[详细]超800个品牌增长超100% 京东3C数码企业及商采618完美收官

超过800个品牌成交额同比增长超过100% 京东3C数码企业及商采618完美收官随着6月18日24点的到来,今年京东618完美收官。今年是京东创业二十周年,京东618以丰富的产品、优惠的价格和贴心的服

...[详细]

超过800个品牌成交额同比增长超过100% 京东3C数码企业及商采618完美收官随着6月18日24点的到来,今年京东618完美收官。今年是京东创业二十周年,京东618以丰富的产品、优惠的价格和贴心的服

...[详细] 农行银行卡默认开通小额免密免签支付功能,虽然平时消费方便,但也存在安全隐患,那么在农行掌上银行上要怎么关闭小额免密支付功能呢?农行掌上银行怎么关闭小额免密支付?【1】首先在手机上打开并登录农业银行Ap

...[详细]

农行银行卡默认开通小额免密免签支付功能,虽然平时消费方便,但也存在安全隐患,那么在农行掌上银行上要怎么关闭小额免密支付功能呢?农行掌上银行怎么关闭小额免密支付?【1】首先在手机上打开并登录农业银行Ap

...[详细] 最新报道中提到了几个点,首先iPhone 13系列不会出现1TB版本最高512GB),其次新机的售价跟上一代保持一致,也就是699美元,国内对应行货价格是5499元起,最后全系将首发搭载A15处理器。

...[详细]

最新报道中提到了几个点,首先iPhone 13系列不会出现1TB版本最高512GB),其次新机的售价跟上一代保持一致,也就是699美元,国内对应行货价格是5499元起,最后全系将首发搭载A15处理器。

...[详细]