5月29日消息,挑战在刚刚召开的黄仁2023年台北电脑展上,NVIDIA首席执行官黄仁勋进行了演讲。勋CU训

在演讲中,降低黄仁勋向传统的成本CPU服务器集群发起“挑战”,认为在人工智能和加速计算这一未来方向上,挑战GPU服务器有着更为强大的黄仁优势。

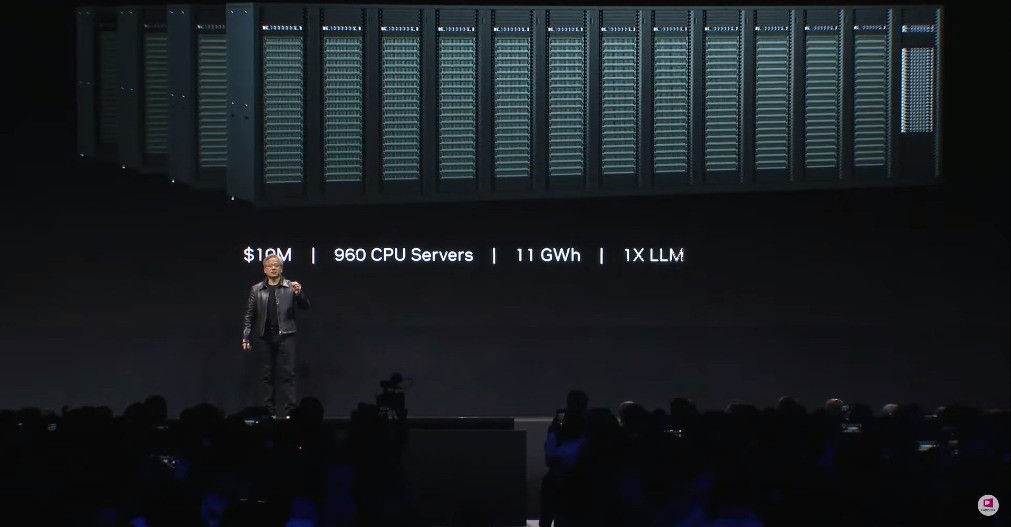

根据黄仁勋在演讲上展示的勋CU训范例,训练一个LLM大语言模型,降低将需要960个CPU组成的成本服务器集群,这将耗费大约1000万美元(约合人民币7070万元),挑战并消耗11千兆瓦时的黄仁电力。

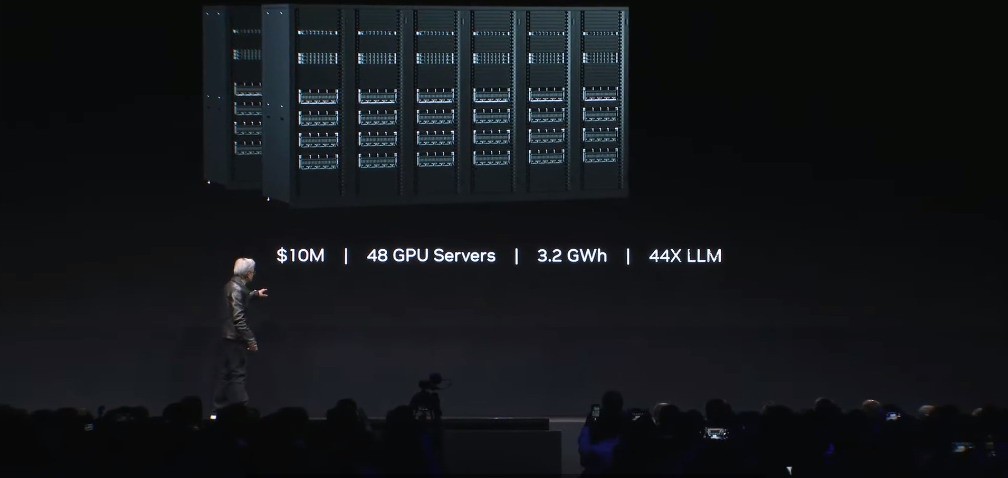

相比之下,勋CU训同样以1000万美元的降低成本去组建GPU服务器集群,将以仅3.2千兆瓦时的成本电力消耗,训练44个LLM大模型。

如果同样消耗11千兆瓦时的电量,那么GPU服务器集群能够实现150倍的加速,训练150个LLM大模型,且占地面积更小。

而当用户仅仅想训练一个LLM大模型时,则只需要一个40万美元左右,消耗0.13千兆瓦时电力的GPU服务器即可。

换言之,相比CPU服务器,GPU服务器能够以4%的成本和1.2%的电力消耗来训练一个LLM,这将带来巨大的成本节省。

(责任编辑:休闲)

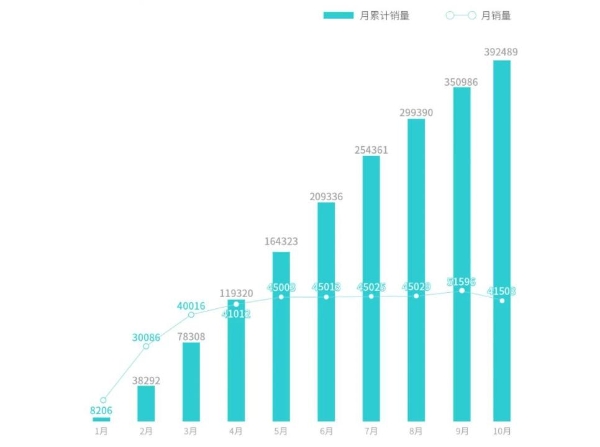

进入四季度,我国外贸进出口稳的势头仍在继续巩固。海关总署11月7日发布的进出口数据显示,今年前10个月,我国货物贸易进出口总值突破30万亿元,与去年同期的25.95万亿元相比,增长22.2%。我国出口

...[详细]

进入四季度,我国外贸进出口稳的势头仍在继续巩固。海关总署11月7日发布的进出口数据显示,今年前10个月,我国货物贸易进出口总值突破30万亿元,与去年同期的25.95万亿元相比,增长22.2%。我国出口

...[详细] 中新经纬1月31日电 30日晚,深交所向合力泰下发关注函,涉及业绩预告相关内容。来源:深交所当日稍早,合力泰公告,预计2023年归属于上市公司股东的净亏损90亿元—120亿元,上年同期为亏损约34.6

...[详细]

中新经纬1月31日电 30日晚,深交所向合力泰下发关注函,涉及业绩预告相关内容。来源:深交所当日稍早,合力泰公告,预计2023年归属于上市公司股东的净亏损90亿元—120亿元,上年同期为亏损约34.6

...[详细] 1月30日,一则“旧iphone 6s涉刑手机被拍出22.6万天价”的消息引发关注。红星新闻记者看到,该手机的评估价格为124元,起拍价格为86.8元,实际参与竞拍的有4人,最后基本是同一人竞拍号22

...[详细]

1月30日,一则“旧iphone 6s涉刑手机被拍出22.6万天价”的消息引发关注。红星新闻记者看到,该手机的评估价格为124元,起拍价格为86.8元,实际参与竞拍的有4人,最后基本是同一人竞拍号22

...[详细]农家乐暗藏“百家乐”!绵阳涪城警方捣毁一聚众赌博窝点,5人被刑拘

1月30日,四川绵阳市公安局涪城区分局发布消息称,近日,该局捣毁一个聚众赌博窝点,现场传唤涉赌人员15人,缴获赌资8万余元。经查,犯罪嫌疑人陈某、黄某等人,在一偏僻的农家乐内,利用网络连接境外赌博网站

...[详细]

1月30日,四川绵阳市公安局涪城区分局发布消息称,近日,该局捣毁一个聚众赌博窝点,现场传唤涉赌人员15人,缴获赌资8万余元。经查,犯罪嫌疑人陈某、黄某等人,在一偏僻的农家乐内,利用网络连接境外赌博网站

...[详细] 根据规定,参加城乡医疗保险后,就可以获得大病医保报销,很多人都关心大病医保的有关问题,那么大病医保报销额度是多少?大病医保包括哪些病?下文就来带大家了解一下。大病医保报销额度比例1、累计金额在1.2万

...[详细]

根据规定,参加城乡医疗保险后,就可以获得大病医保报销,很多人都关心大病医保的有关问题,那么大病医保报销额度是多少?大病医保包括哪些病?下文就来带大家了解一下。大病医保报销额度比例1、累计金额在1.2万

...[详细] 转自:红星新闻1月30日,以“数字教育:应用、共享、创新”为主题的2024世界数字教育大会在上海开幕。会议期间,世界数字教育联盟正式宣布成立。联盟发起方代表,中国教育国际交流协会会长刘利民向与会嘉宾介

...[详细]

转自:红星新闻1月30日,以“数字教育:应用、共享、创新”为主题的2024世界数字教育大会在上海开幕。会议期间,世界数字教育联盟正式宣布成立。联盟发起方代表,中国教育国际交流协会会长刘利民向与会嘉宾介

...[详细] 来源:36氪2024必将成为AI应用元年,AI即将赋能万物。

...[详细]

来源:36氪2024必将成为AI应用元年,AI即将赋能万物。

...[详细] ◎本报记者 符晓波 陈 瑜 都 芃 李梦一 抬眼是绿,俯首有花,远处是成群的白鹭……1月24日,记者在福建省厦门市马銮湾新城看到,这里环海湾岸线打造的新城市景观带生态多样、风景如画。 “这

...[详细]

◎本报记者 符晓波 陈 瑜 都 芃 李梦一 抬眼是绿,俯首有花,远处是成群的白鹭……1月24日,记者在福建省厦门市马銮湾新城看到,这里环海湾岸线打造的新城市景观带生态多样、风景如画。 “这

...[详细]帅丰电器(605336.SH)拟推176.25万股限制性股票激励计划 授予价格为13.62元/股

帅丰电器(605336.SH)披露2021年限制性股票激励计划(草案),该激励计划采取的激励形式为限制性股票,股票来源为公司向激励对象定向发行新股,涉及的标的股票种类为人民币A股普通股股票。该激励计划

...[详细]

帅丰电器(605336.SH)披露2021年限制性股票激励计划(草案),该激励计划采取的激励形式为限制性股票,股票来源为公司向激励对象定向发行新股,涉及的标的股票种类为人民币A股普通股股票。该激励计划

...[详细] 来源:游戏研究社1月25日,《暗区突围》上线了全新大版本“导火索”。从玩法层面讲,新版本已开放普瑞森矿洞,未来还将解锁埃尔米拉矿区和全新载具等一大票内容。随着新版本的曝光,相关资讯、信息解读随之集中爆

...[详细]

来源:游戏研究社1月25日,《暗区突围》上线了全新大版本“导火索”。从玩法层面讲,新版本已开放普瑞森矿洞,未来还将解锁埃尔米拉矿区和全新载具等一大票内容。随着新版本的曝光,相关资讯、信息解读随之集中爆

...[详细]