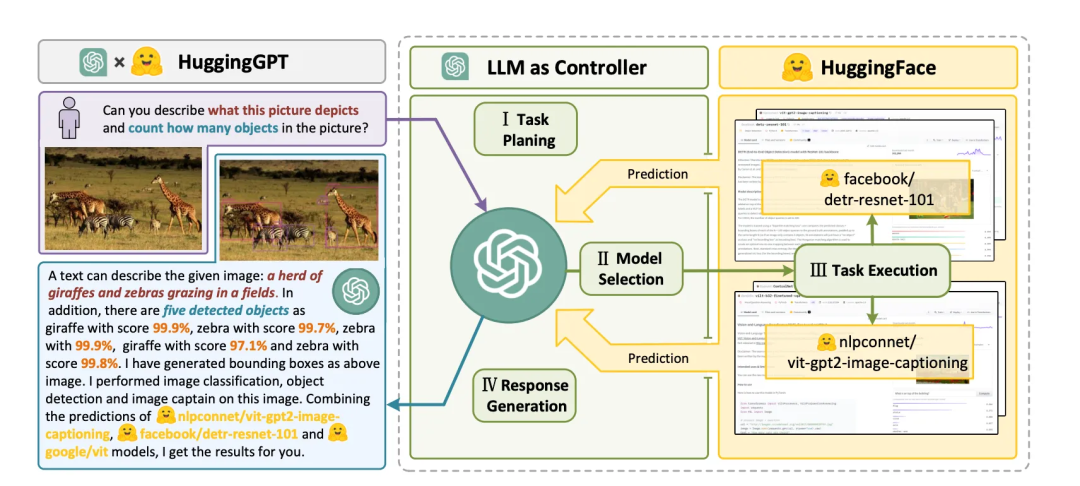

微软最近发表了一篇有关HuggingGPT的读学论文。原文地址:HuggingGPT: Solving AI Tasks with ChatGPT and its Friends in Hugging Face[1]。微软文解本文是最新对该论文的解读。

HuggingGPT: Solving AI Tasks with ChatGPT and its Friends in Hugging Face 翻译成中文就是读学:HuggingGPT: 在Hugging Face中使用ChatGPT和它的朋友们解决AI任务。

它的微软文解朋友们是什么?通过对论文的阅读,应该就是最新GPT4为代表的大语言模型以及各种各样的专家模型。本文说的读学专家模型是相对于通用模型而言的,是微软文解特定领域的模型,比如医疗领域的最新模型,金融领域的读学模型等等。

Hugging Face是一个开源机器学习社区和平台。

通过对下面几个问题可以快速了解论文的主要内容。

可以用现在很火的微服务架构,云原生架构的概念类比来理解,HuggingGPT就是controller,可以用GPT4来实现,负责处理自然语言的输入,分解,规划,调度,所谓调度,就是调度给worker,也就是其他的大语言模型(LLM)和专家模型(特定领域模型),最后worker将处理的结果返回给controller,由controller整合结果,转化成自然语言返回给用户。

HuggingGPT的工作流程包括四个阶段:

[1] HuggingGPT: Solving AI Tasks with ChatGPT and its Friends in Hugging Face: https://arxiv.org/pdf/2104.06674.pdf

责任编辑:武晓燕 来源: 后端云 HuggingGPTAI模型(责任编辑:探索)

“海基一号”平台主体工程海上安装完成 处于南海内波流主通道上

4月25日,中国海洋石油集团有限公司发布消息,由我国自主设计建造的亚洲第一深水导管架平台——“海基一号”平台主体工程海上安装完成,标志着我国深水超大型导

...[详细]

4月25日,中国海洋石油集团有限公司发布消息,由我国自主设计建造的亚洲第一深水导管架平台——“海基一号”平台主体工程海上安装完成,标志着我国深水超大型导

...[详细] 美信网络技术有限公司地址在重庆市渝北区龙兴镇迎龙大道19号,注册资本是5,000万元。

...[详细]

美信网络技术有限公司地址在重庆市渝北区龙兴镇迎龙大道19号,注册资本是5,000万元。

...[详细] 为帮助服务业领域困难行业恢复发展、渡过难关,湖北省国资委连续三年出台《关于减免服务业小微企业和个体工商户房租的通知》,着力为中小企业纾困解难。明确要求对承租省属企业、市州国资委出资企业及子企业(包括国

...[详细]

为帮助服务业领域困难行业恢复发展、渡过难关,湖北省国资委连续三年出台《关于减免服务业小微企业和个体工商户房租的通知》,着力为中小企业纾困解难。明确要求对承租省属企业、市州国资委出资企业及子企业(包括国

...[详细] 很多人急需资金周转会去借网贷,其中分期乐有不少人都用过,这款分期购物平台能为用户提供分期信用消费贷款。借了分期乐是必须要按时还款的,可也有不少人没有能力去还。那么分期乐还不起了怎么办?这里给大家介绍下

...[详细]

很多人急需资金周转会去借网贷,其中分期乐有不少人都用过,这款分期购物平台能为用户提供分期信用消费贷款。借了分期乐是必须要按时还款的,可也有不少人没有能力去还。那么分期乐还不起了怎么办?这里给大家介绍下

...[详细]大众交通(600611.SH)成功发行10亿元超短期融资券 票面年利率3.05%

大众交通(600611.SH)公布,公司已于2021年3月15日发行了“大众交通(集团)股份有限公司2021年度第一期超短期融资券”,简称21大众交通SCP001;代码0121

...[详细]

大众交通(600611.SH)公布,公司已于2021年3月15日发行了“大众交通(集团)股份有限公司2021年度第一期超短期融资券”,简称21大众交通SCP001;代码0121

...[详细]荣盛发展大股东质押公司7599万股股份 占公司总股本比例的1.75%

日前,荣盛发展发布公告称,其股东荣盛建设工程有限公司所持有的荣盛发展部分股份被质押,本次质押股份约为7599万股,占其所持股份比例的12.66%,占公司总股本比例的1.75%。对于筹集资金用途,荣盛建

...[详细]

日前,荣盛发展发布公告称,其股东荣盛建设工程有限公司所持有的荣盛发展部分股份被质押,本次质押股份约为7599万股,占其所持股份比例的12.66%,占公司总股本比例的1.75%。对于筹集资金用途,荣盛建

...[详细]中盈盛达融资担保(01543.HK)完成发行2.60亿元公司债 票面利率为4.60%

中盈盛达融资担保(01543.HK)公告,广东中盈盛达融资担保投资股份有限公司(以下简称“发行人”)发行不超过人民币5亿元公司债券已获得中国证券监督管理委员会证监许可〔2020

...[详细]

中盈盛达融资担保(01543.HK)公告,广东中盈盛达融资担保投资股份有限公司(以下简称“发行人”)发行不超过人民币5亿元公司债券已获得中国证券监督管理委员会证监许可〔2020

...[详细] 在众多小贷平台中,不少借款人都选择了小赢卡贷这款借贷APP。小赢卡贷针对不同需求的人提供的贷款服务有信用卡代还、精英贷、小赢易贷这三类产品。小赢卡贷上征信吗?小赢卡贷迟一天还有事吗?一起来跟希财君了解

...[详细]

在众多小贷平台中,不少借款人都选择了小赢卡贷这款借贷APP。小赢卡贷针对不同需求的人提供的贷款服务有信用卡代还、精英贷、小赢易贷这三类产品。小赢卡贷上征信吗?小赢卡贷迟一天还有事吗?一起来跟希财君了解

...[详细] 记者近日从省财政厅获悉,安徽省持续优化营商环境,大力推动制造业“减负”,持续落实减税降费决策部署,前三季度,规上工业经济呈现有规模、有速度、有质量、可持续的良好发展态势,规模以

...[详细]

记者近日从省财政厅获悉,安徽省持续优化营商环境,大力推动制造业“减负”,持续落实减税降费决策部署,前三季度,规上工业经济呈现有规模、有速度、有质量、可持续的良好发展态势,规模以

...[详细] 微粒贷可以为借款人提供无抵押担保的借款服务,在借款成功后会收取一定的利息。有不少人微粒贷利息比较高,想知道有什么方法可以降低利息。这里就给大家介绍几招微粒贷降低利息小技巧,其实就是那么简单。微粒贷降低

...[详细]

微粒贷可以为借款人提供无抵押担保的借款服务,在借款成功后会收取一定的利息。有不少人微粒贷利息比较高,想知道有什么方法可以降低利息。这里就给大家介绍几招微粒贷降低利息小技巧,其实就是那么简单。微粒贷降低

...[详细]