近日,码大模型开源了文生图神器 Stable Diffusion 的上下 Stability Al 又发布了新的大模型 ——StableCode,其首个用于编码的文窗生成式 AI 大模型。Stability Al 对它的口万描述是「革命性的」。

据介绍,参数StableCode 旨在帮助程序员处理日常工作,码大模型同时为新手开发者提供了一个很好的上下学习工具,让他们的文窗技能更上一层楼。

官博地址:https://stability.ai/blog/stablecode-llm-generative-ai-coding

对于 StableCode,口万网友的参数期许很高,表示真的码大模型需要将整个代码库作为上下文的代码大模型。

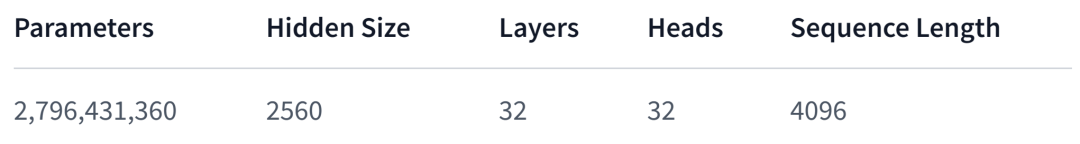

StableCode 通过三个不同版本的模型来帮助开发者变得更加高效。其中基础模型为「StableCode-Completion-Alpha-3B-4K」,它是一个 30 亿参数的仅使用解码器的代码补全模型。

该基础模型在来自 BigCode stack 数据集的各种编程语言上进行了预训练,并对 Python、Go、Java、Javascript、C、markdown 和 C++ 等流行编程语言进行了针对性训练。总的来说,StableCode 在 HPC 集群上进行 5600 亿 token 代码的训练。

这里的 BigCode 是 2022 年 9 月 HuggingFace 与 ServiceNow Research 联合发起的一个代码大模型项目,旨在围绕 AI 代码生成工具建立一个开放社区并开发大语言模型代码。

Huggingface:https://huggingface.co/stabilityai/stablecode-completion-alpha-3b-4k

在基础模型的基础上,针对特定用例进行调整的指令模型「StableCode-Instruct-Alpha-3B」帮助解决复杂的编程任务。该模型同样是 30 亿参数的仅使用解码器的指令调整代码模型,在 stackoverflow 开发者调查报告中排名靠前的编程语言上进行了预训练。

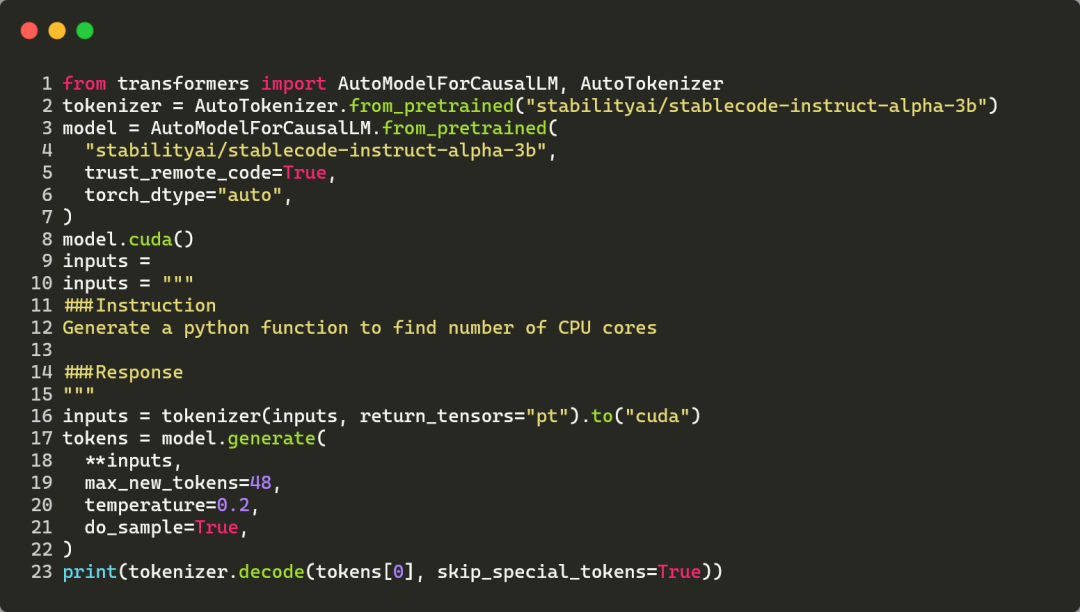

同时在基础模型上对 Alpaca 格式的约 12 万个代码指令 - 响应对进行了训练。下图为使用 StableCode 指令模型为给定指令生成响应的代码示例。

Huggingface 地址:https://huggingface.co/stabilityai/stablecode-instruct-alpha-3b

对于想要学习更多编码技能的人来说,StableCode 是理想的构建块。长上下文窗口模型「StableCode-Completion-Alpha-3B」可称得上完美的助手,确保用户使用单行和多行自动代码补全建议。

该模型也是 30 亿参数的仅使用解码器的代码补全模型,在 2023 年 stackoverflow 开发者调查报告中最多使用的编程语言上进行了预训练。

与以往发布的开源模型相比,该模型的上下文窗口达到了 16000 token(比任何其他模型都大),一次性可以处理的代码更多,是以往的 2-4 倍。这使得用户可以查看或编辑五个中等大小的 Python 文件,成为新手的理想学习工具。

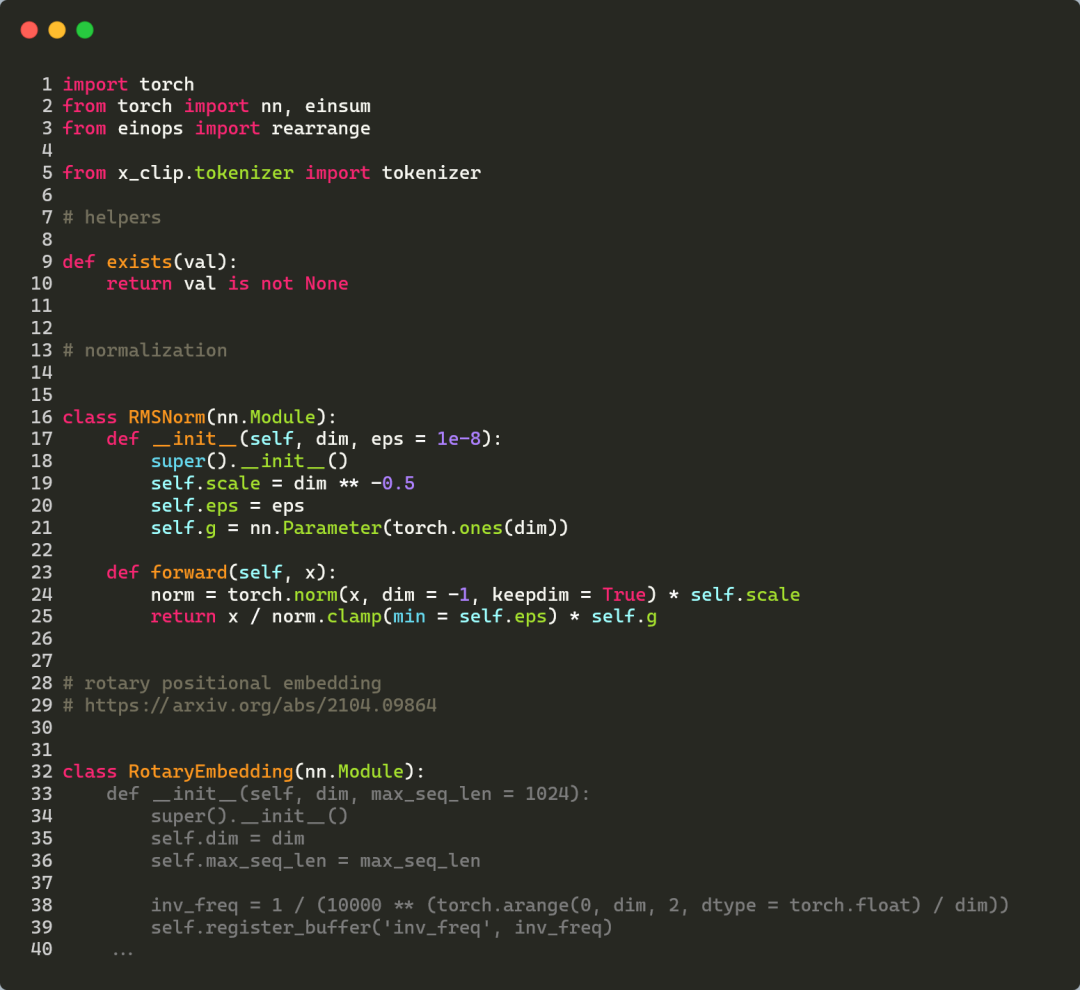

如下图所示,StableCode 利用 Pytorch 深度学习库补全了一个比较复杂的 Python 文件,其中灰色代码为 StableCode 的预测结果。

Huggingface 地址:https://huggingface.co/stabilityai/stablecode-completion-alpha-3b

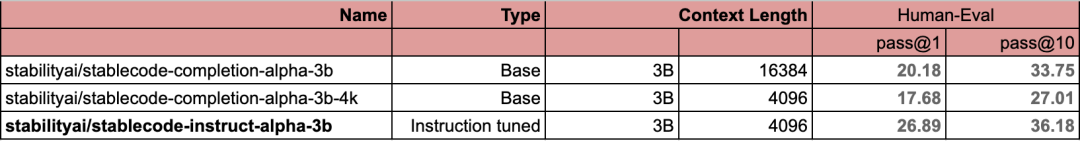

下表为 StableCode 三个版本模型的基准分数。

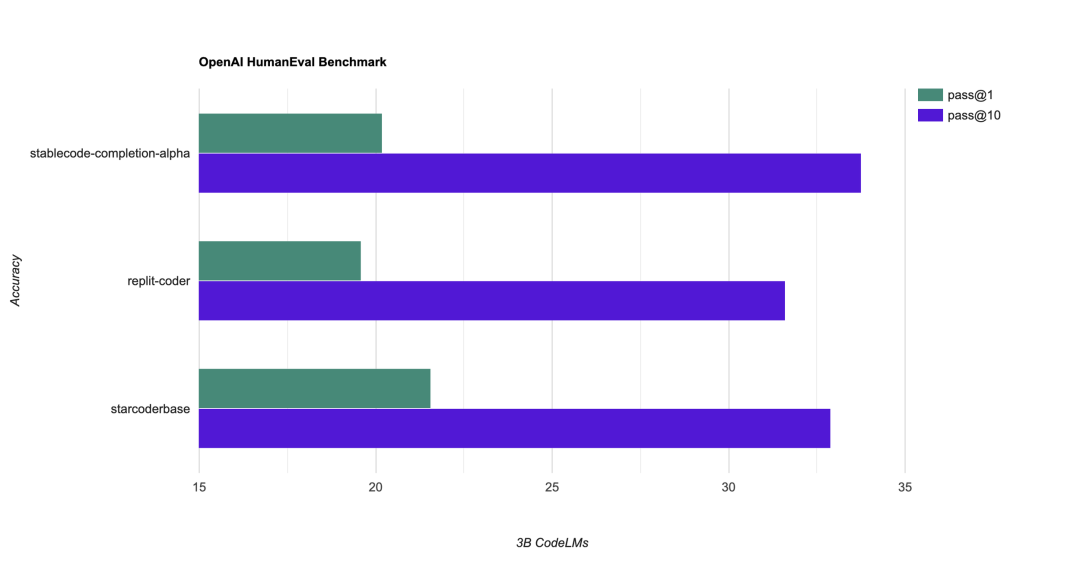

StableCode 还与类似参数量和 token 数量的同级别模型(30 亿参数)进行比较,其中在流行的 HumanEval 基准上使用了 pass@1 和 pass@10 指标。

从下图可以看到,在与 replit-coder(AI 编程独角兽 Replit 推出)、starcoderbase 的比较中,StableCode 的 pass@1 强于 replit-coder 弱于 starcoderbase、pass@10 强于两者。

原文链接:https://stability.ai/blog/stablecode-llm-generative-ai-coding

责任编辑:张燕妮 来源: 机器之心 代码模型(责任编辑:休闲)

发行注册制,常态化退市注册制在科创板试行一年有余,有近200家公司成功IPO,这些公司在技术研发方面普遍具有优势,IPO将促使这200家公司进入发展的快车道。对A股估值的影响注册制推行对a股估值影响要

...[详细]

发行注册制,常态化退市注册制在科创板试行一年有余,有近200家公司成功IPO,这些公司在技术研发方面普遍具有优势,IPO将促使这200家公司进入发展的快车道。对A股估值的影响注册制推行对a股估值影响要

...[详细] 记者从中国物流与采购联合会获悉,2021年4月份中国公路物流运价指数为100.2点,比上月回落0.07%,比去年同期回升1.7%。从各周指数看,第二、三周运价指数环比回升,第一、四、五周运价指数环比回

...[详细]

记者从中国物流与采购联合会获悉,2021年4月份中国公路物流运价指数为100.2点,比上月回落0.07%,比去年同期回升1.7%。从各周指数看,第二、三周运价指数环比回升,第一、四、五周运价指数环比回

...[详细] 日前,国家发展改革委、工业和信息化部、财政部、人民银行联合印发了《关于做好2021年降成本重点工作的通知》(以下简称《通知》),提出了2021年降低实体经济企业成本工作部际联席会议将重点组织落实的8个

...[详细]

日前,国家发展改革委、工业和信息化部、财政部、人民银行联合印发了《关于做好2021年降成本重点工作的通知》(以下简称《通知》),提出了2021年降低实体经济企业成本工作部际联席会议将重点组织落实的8个

...[详细]中嘉博创(000889.SZ):中兆投资1月12日以来减持约1.0470亿股

中嘉博创(000889.SZ)公布,公司于2021年3月2日收到持股5%以上股东中兆投资出具的《减持中嘉博创股票的告知函》,自2021年1月12日-3月2日期间,中兆投资通过集中竞价和大宗交易方式合计

...[详细]

中嘉博创(000889.SZ)公布,公司于2021年3月2日收到持股5%以上股东中兆投资出具的《减持中嘉博创股票的告知函》,自2021年1月12日-3月2日期间,中兆投资通过集中竞价和大宗交易方式合计

...[详细]华电国际(600027.SH)公布消息:拟购买蒙东能源45.15%股权及福源热电36.86%股权

华电国际(600027.SH)公布,上市公司拟向建信投资和中银投资发行普通股A股和可转换公司债券购买其分别持有的蒙东能源45.15%股权和福源热电36.86%股权,其中以发行股份、可转换公司债券支付的

...[详细]

华电国际(600027.SH)公布,上市公司拟向建信投资和中银投资发行普通股A股和可转换公司债券购买其分别持有的蒙东能源45.15%股权和福源热电36.86%股权,其中以发行股份、可转换公司债券支付的

...[详细] 据汤森路透GFMS预期,2017年印度的黄金进口量同比出现了大幅增加。GFMS数据称,去年全年印度总计进口了855吨黄金,同比大增67%。此外,未加工金块进口大增80%至213吨,创下历史新高。数据还

...[详细]

据汤森路透GFMS预期,2017年印度的黄金进口量同比出现了大幅增加。GFMS数据称,去年全年印度总计进口了855吨黄金,同比大增67%。此外,未加工金块进口大增80%至213吨,创下历史新高。数据还

...[详细]外资控股券商设立节奏明显加速 3家已就位 18家合资券商排队候场

编者按:从2003年算起,合资券商在中国证券市场已走过15年风雨历程,2003年至2012年,十几家合资券商相继设立。但多年来合资券商多困扰于业务开展以及管理方式的“水土不服”

...[详细]

编者按:从2003年算起,合资券商在中国证券市场已走过15年风雨历程,2003年至2012年,十几家合资券商相继设立。但多年来合资券商多困扰于业务开展以及管理方式的“水土不服”

...[详细] 国家外汇管理局7日公布的国际收支平衡表初步数据显示,今年一季度,来华直接投资净流入931亿美元,达历史较高值,体现外国投资者对我国疫情防控和经济发展前景的信心。同期,我国对外直接投资净流出226亿美元

...[详细]

国家外汇管理局7日公布的国际收支平衡表初步数据显示,今年一季度,来华直接投资净流入931亿美元,达历史较高值,体现外国投资者对我国疫情防控和经济发展前景的信心。同期,我国对外直接投资净流出226亿美元

...[详细] 自今年4月27日大盘创下2863点的年内新低后,逐渐震荡企稳站上3000点,近来新能源板块成为反弹急先锋。期间,新能源主题基金及重仓新能源板块的基金也大幅“回血”。基金经理表示

...[详细]

自今年4月27日大盘创下2863点的年内新低后,逐渐震荡企稳站上3000点,近来新能源板块成为反弹急先锋。期间,新能源主题基金及重仓新能源板块的基金也大幅“回血”。基金经理表示

...[详细]112家企业申请在科创板上市:京沪两地占比超四成 江浙粤排名居前

虽然距离3月18日上交所科创板上市审核系统正式对外“接单”仅过去73天,但据《证券日报》记者统计,截至5月29日记者发稿,已有112家企业申请在科创板上市,其中,已受理17家,

...[详细]

虽然距离3月18日上交所科创板上市审核系统正式对外“接单”仅过去73天,但据《证券日报》记者统计,截至5月29日记者发稿,已有112家企业申请在科创板上市,其中,已受理17家,

...[详细]