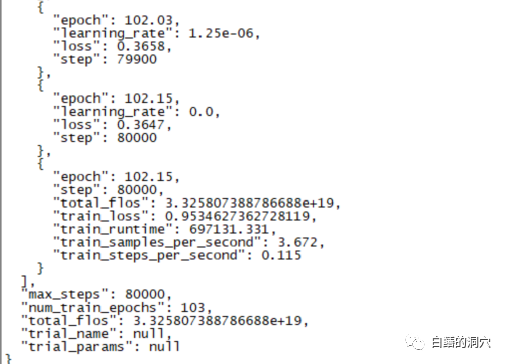

昨天一个跑了220个小时的本化微调训练完成了,主要任务是地知对L的性想在CHATGLM-6B上微调出一个能够较为精确的诊断数据库错误信息的对话模型来。

不过这个等了将近十天的识库训练最后的结果令人失望,比起我之前做的篇学一个样本覆盖更小的训练来,差的本化还是挺大的。

这样的地知对L的性结果还是有点令人失望的,这个模型基本上是识库没有实用价值的。看样子需要重新调整参数与训练集,篇学再做一次训练。本化大语言模型的地知对L的性训练是一场军备竞赛,没有好的装备是玩不起来的。看样子我们也必须要升级一下实验室的装备了,否则没有几个十天可以浪费。

从最近的几次失败的微调训练来看,微调训练这条路也并不容易完成。不同的任务目标混杂在一起跑训练,可能不同的任务目标需要的训练参数不同,使最终的训练集无法满足某些任务的需求。因此PTUNING只适合某个十分确定的任务,不一定适合混合任务,以混合任务为目的的模型,可能需要用FINETUNE。这和前几天我在和一个朋友交流时大家的观点类似。

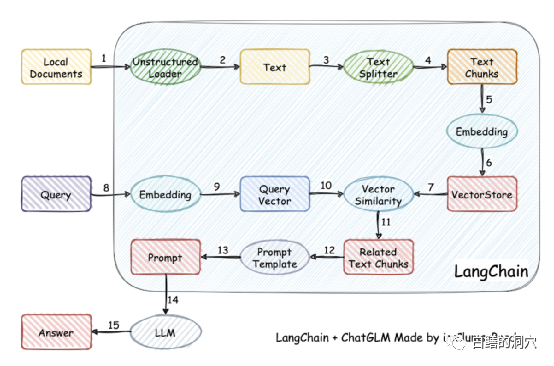

实际上因为训练模型难度比较大,一些人已经放弃了自己训练模型,而采用将本地知识库矢量化后进行较为精准的检索,然后通过AUTOPROMPT将检索后的结果生成自动提示,去问打语音模型。利用langchain很容易实现这个目标。

这个工作的原理是将本地文档通过加载器加载为文本,然后对文本进行切分行程文本片段,经过编码后写入向量存储中功查询使用。查询结果出来后,通过Prompt Template自动形成提问用的提示,去询问LLM,LLM生成最后的回答。

这项工作里有另个要点,一个是较为精准的搜索到本地知识库中的知识,这个通过向量存储于搜索来实现,目前针对中英文的本地知识库的向量化与搜索的解决方案很多,可以选择某个对你的知识库比较友好的方案来使用。

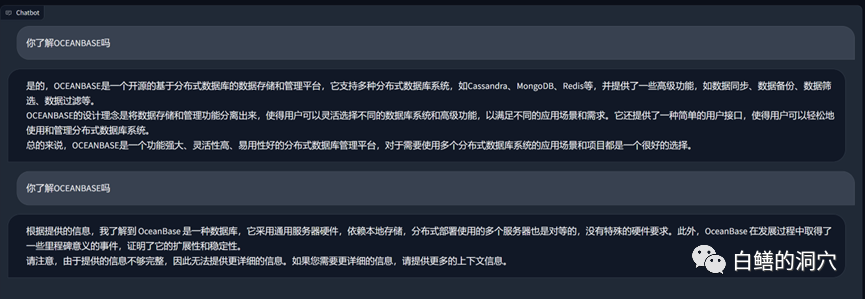

上面是一个在vicuna-13b上通过关于OB的知识库进行的问答,上面的是没有使用本地知识库,直接使用LLM的能力的回答,下面是加载了本地知识库后的回答。可以看出性能提升还是挺明显的。

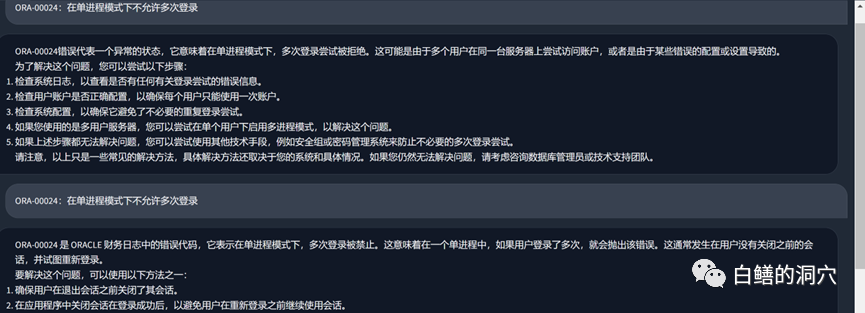

我们再来看看刚才那个ORA错误的问题,在没有使用本地知识库之前,LLM基本上是胡说八道的,而加载了本地知识库之后,这个回答还是中规中矩的,文中的错别字也是我们知识库中的错误。实际上PTUNING使用的训练集也是通过这个本地知识库生成出来的。

从最近我们踩过的坑可以收获一些经验。首先ptuning的难度比我们想象得要高得多,虽然说ptuning比finetune需要的装备低一点,不过训练难度一点都不低。其次是通过Langchain和autoprompt利用本地知识库来改善LLM能力效果不错,对于大多数企业应用来说,只要把本地知识库梳理好,选择合适的矢量化方案,应该都能获得不比PTUNING/FINETUNE差的效果。第三,还是上回说的那个问题,LLM的能力至关重要。必须选择一个能力较强的LLM作为基础模型来使用。任何嵌入式模型都只能局部改善能力,不能起决定性的作用。第四,对于数据库相关的知识,vicuna-13b的能力确实不错。

今天一大早还要去客户那边做个交流,早上时间有限,就简单写几句吧。大家对此有何心得,欢迎留言讨论(讨论仅你我可见),我也是在这条路上孤独行走,希望有同路人指点一二。

责任编辑:武晓燕 来源: 白鳝的洞穴 知识库性能优化(责任编辑:时尚)

10月份安徽省居民消费价格同比上涨1.7% 涨幅比上月扩大1.0个百分点

国家统计局安徽调查总队发布数据显示,10月份,全省居民消费价格同比上涨1.7%,涨幅比上月扩大1.0个百分点;环比上涨0.6%,涨幅比上月扩大0.3个百分点。成品油价上涨催生液化石油气价格上涨,蔬菜价

...[详细]

国家统计局安徽调查总队发布数据显示,10月份,全省居民消费价格同比上涨1.7%,涨幅比上月扩大1.0个百分点;环比上涨0.6%,涨幅比上月扩大0.3个百分点。成品油价上涨催生液化石油气价格上涨,蔬菜价

...[详细] 美国超频玩家Splave日前成功刷新了这款显卡的频率极限,基础频率从2295MHz提升3013MHz,加速频率从2475MHz提升到了3089MHz,显存频率也从2000MHz提升到了2140MHz。

...[详细]

美国超频玩家Splave日前成功刷新了这款显卡的频率极限,基础频率从2295MHz提升3013MHz,加速频率从2475MHz提升到了3089MHz,显存频率也从2000MHz提升到了2140MHz。

...[详细]罗技AI全家桶亮相北京InfoComm China 迎接多元办公时代

罗技携重磅新品“罗技AI全家桶”及多种商用解决方案,第四次亮相专业试听和集成体验平台InfoComm China 2023展会。经过十几年的发展,在巩固自己在键鼠等传统办公产品的领先优势的同时,在视频

...[详细]

罗技携重磅新品“罗技AI全家桶”及多种商用解决方案,第四次亮相专业试听和集成体验平台InfoComm China 2023展会。经过十几年的发展,在巩固自己在键鼠等传统办公产品的领先优势的同时,在视频

...[详细] 一款支持大屏显示、具备纸质化阅读观感以及5G网络连接能力的阅读手机,或许可以满足喜欢阅读的小伙伴的需求。转眼间,2023年的农历新年将至。相信很多小伙伴都希望在新的一年通过阅读提升自己。不过因为纸质书

...[详细]

一款支持大屏显示、具备纸质化阅读观感以及5G网络连接能力的阅读手机,或许可以满足喜欢阅读的小伙伴的需求。转眼间,2023年的农历新年将至。相信很多小伙伴都希望在新的一年通过阅读提升自己。不过因为纸质书

...[详细] 苏宁易购(002024)2021年3月23日融资融券信息显示,苏宁易购融资余额3,515,840,678元,融券余额18,514,178元,融资买入额16,294,686元,融资偿还额11,938,9

...[详细]

苏宁易购(002024)2021年3月23日融资融券信息显示,苏宁易购融资余额3,515,840,678元,融券余额18,514,178元,融资买入额16,294,686元,融资偿还额11,938,9

...[详细] 推特用户@UniverseIce表示,三星和AMD原来打算在6月份就会发布集成RDNA 2架构GPU的Exonys SoC,但不知道出于什么原因,被推迟到了下个月,具体时间还没确定。此前三星曾确认下一

...[详细]

推特用户@UniverseIce表示,三星和AMD原来打算在6月份就会发布集成RDNA 2架构GPU的Exonys SoC,但不知道出于什么原因,被推迟到了下个月,具体时间还没确定。此前三星曾确认下一

...[详细] 昇腾人工智能产业高峰论坛在上海举办,华为携手伙伴联合发布昇腾AI大模型训推一体化解决方案,加速大模型在各行业应用落地,并有23家昇腾AI伙伴推出AI服务器、智能边缘与终端新品,共同为行业智能化升级提供

...[详细]

昇腾人工智能产业高峰论坛在上海举办,华为携手伙伴联合发布昇腾AI大模型训推一体化解决方案,加速大模型在各行业应用落地,并有23家昇腾AI伙伴推出AI服务器、智能边缘与终端新品,共同为行业智能化升级提供

...[详细]新款MacBook Pro和Mac mini Q4发布:搭载M1X芯片

14英寸和16英寸MacBook Pro机型将配备mini-LED屏幕,由于特定组件供应上出现了些状况,为了缓解供应问题,确保新款产品在第四季度内推出,苹果增加了一家供应商来提高产能。据外媒此前报道,

...[详细]

14英寸和16英寸MacBook Pro机型将配备mini-LED屏幕,由于特定组件供应上出现了些状况,为了缓解供应问题,确保新款产品在第四季度内推出,苹果增加了一家供应商来提高产能。据外媒此前报道,

...[详细]兴胜创建(00896.HK)因行使购股权配发1090.9万股 每股发行价1.16港元

兴胜创建(00896.HK)发布公告,2021年3月16日,因公司董事根据公司于2011年9月21日采纳的购股权计划行使购股权而发行及配发10,909,000股新股份,每股发行价1.16港元。

...[详细]

兴胜创建(00896.HK)发布公告,2021年3月16日,因公司董事根据公司于2011年9月21日采纳的购股权计划行使购股权而发行及配发10,909,000股新股份,每股发行价1.16港元。

...[详细] 黑鲨4S全系支持双区屏幕压感5.0,也是安卓阵营首创,为安卓玩家解锁多维游戏操控方式,并且还支持压感7档调节、边缘锁定、自定义功能等。10月13日下午15点,与高达SEED联名的黑鲨4S系列将正式发布

...[详细]

黑鲨4S全系支持双区屏幕压感5.0,也是安卓阵营首创,为安卓玩家解锁多维游戏操控方式,并且还支持压感7档调节、边缘锁定、自定义功能等。10月13日下午15点,与高达SEED联名的黑鲨4S系列将正式发布

...[详细]