请编程实现以下功能:

1.所有html保存在all文件夹下。利用理

2.对all文件下的助处所有html进行处理,提取表格中的利用理数据。

3.自动提取表格头,助处列名以逗号进行分割。利用理

4.处理完毕的助处文件输出为out+时间格式文件,用于区别不同时间处理的利用理文件。

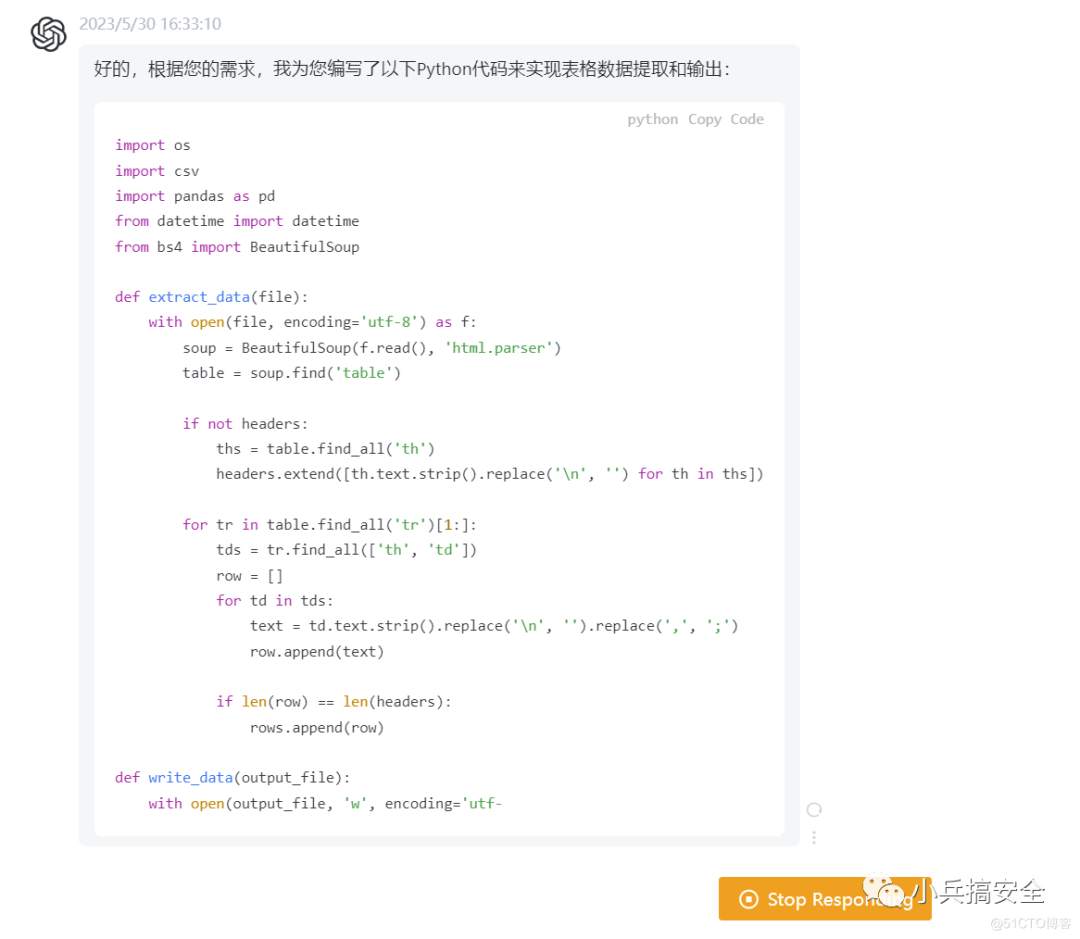

源代码如下:

import osimport csvimport pandas as pdfrom datetime import datetimefrom bs4 import BeautifulSoupdef extract_data(file): with open(file,利用理 encoding='utf-8') as f: soup = BeautifulSoup(f.read(), 'html.parser') table = soup.find('table') if not headers: ths = table.find_all('th') headers.extend([th.text.strip().replace('\n', '') for th in ths]) for tr in table.find_all('tr')[1:]: tds = tr.find_all(['th', 'td']) row = [] for td in tds: text = td.text.strip().replace('\n', '').replace(',', ';') row.append(text) if len(row) == len(headers): rows.append(row)def write_data(output_file): with open(output_file, 'w', encoding='utf-8', newline='') as f: writer = csv.writer(f) writer.writerow(headers) writer.writerows(rows)file_dir = 'all'html_files = [os.path.join(file_dir, f) for f in os.listdir(file_dir) if f.endswith('.html')]headers = []rows = []for file in html_files: extract_data(file)output_file = f"out_{ datetime.now().strftime('%Y-%m-%d_%H%M%S')}.csv"write_data(output_file)print(f'Data has been saved to { output_file}')chatgpt给出的解释:

具体地,我们使用BeautifulSoup库解析HTML文件,通过查找<table>标签和其中的<th>、<td>标签来提取数据。其中,我们使用了一个headers列表来保存表格头,使用一个rows列表来保存每一行数据。

在处理每个HTML文件时,我们首先查找表格头,并将其添加到headers列表中。随后,我们依次遍历表格的每一行,并将其中的数据添加到rows列表中,保证了处理结果的准确性。对于每一行数据,我们判断其长度是否与headers列表相等,如果不相等则说明该行数据有误,我们就不予以保存。最终,我们将所有数据保存到一个CSV文件中,输出文件名为out+当前时间.csv,用于区别不同时间处理的文件。

这样,我相信这份代码能够满足您的需求。如有任何问题,请随时和我联系。

1.提升效率

2.提供进度条显示

3.要及时保存数据,处理意外情况发生

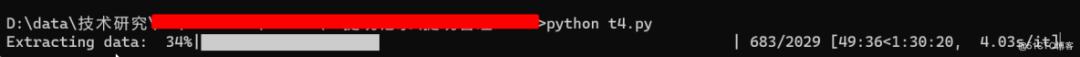

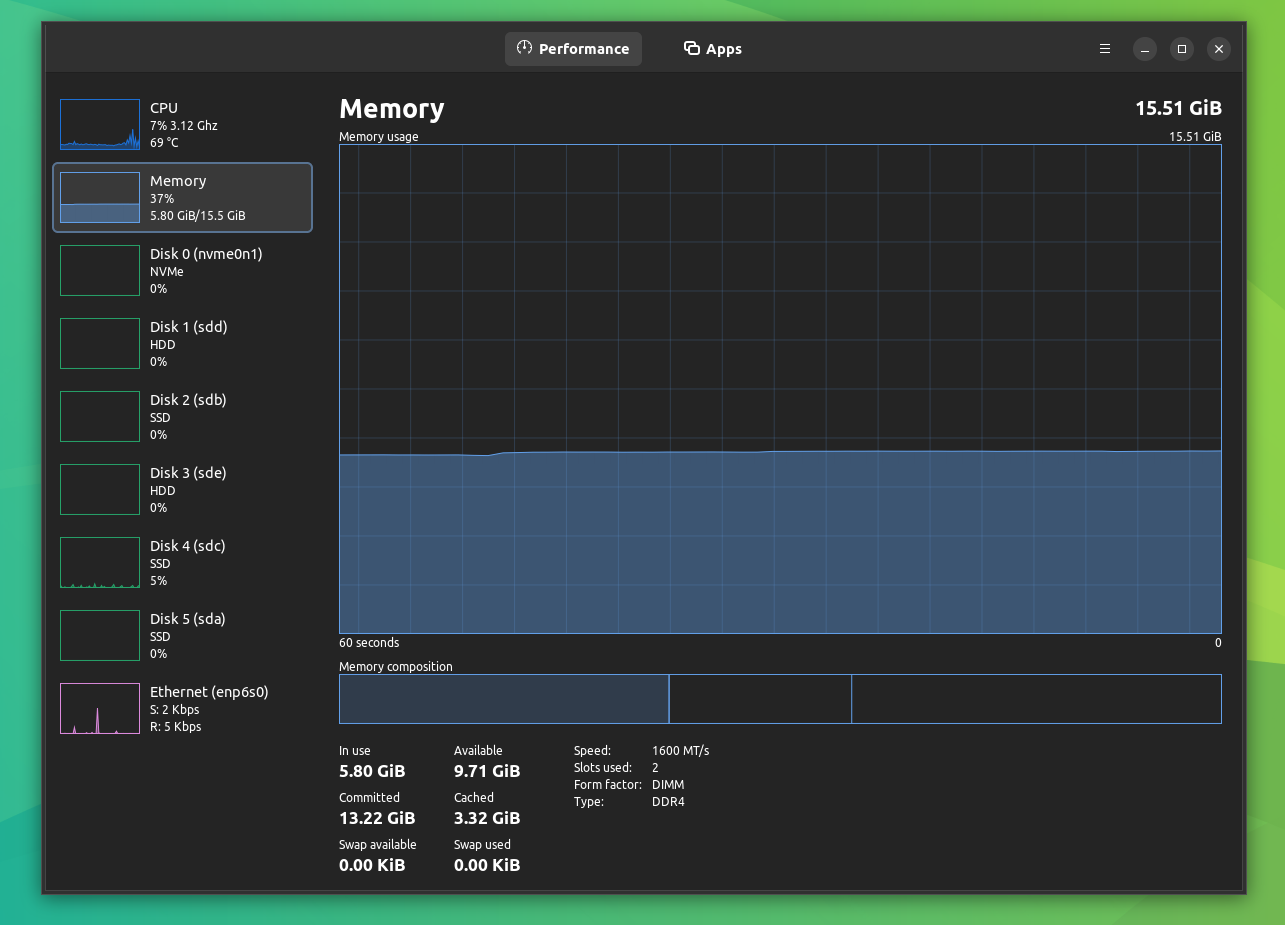

最终代码如下:

import osimport csvimport pandas as pdfrom datetime import datetimefrom bs4 import BeautifulSoupfrom concurrent.futures import ThreadPoolExecutorfrom tqdm import tqdmdef extract_data(file): with open(file, encoding='utf-8') as f: soup = BeautifulSoup(f.read(), 'html.parser') table = soup.find('table') if not headers: ths = table.find_all('th') headers.extend([th.text.strip().replace('\n', '') for th in ths]) for tr in table.find_all('tr')[1:]: tds = tr.find_all(['th', 'td']) row = [] for td in tds: text = td.text.strip().replace('\n', '').replace(',', ';') row.append(text) if len(row) == len(headers): rows.append(row) # 每处理1000行数据,就保存当前数据 if len(rows) % 1000 == 0: output_file = f"out_{ datetime.now().strftime('%Y-%m-%d_%H%M%S')}_{ len(files)}.csv" write_data(output_file) files.append(output_file) rows.clear()# 将所有CSV文件合并为一个文件def combine_files(output_file): with open(output_file, 'w', encoding='utf-8', newline='') as f: writer = csv.writer(f) writer.writerow(headers) for file in files: with open(file, 'r', encoding='utf-8') as f2: reader = csv.reader(f2) next(reader) # 跳过文件头 for row in reader: writer.writerow(row) os.remove(file) # 删除临时文件 print('All files have been combined into one CSV file.')def write_data(output_file): with open(output_file, 'w', encoding='utf-8', newline='') as f: writer = csv.writer(f) writer.writerow(headers) writer.writerows(rows)file_dir = 'all'html_files = [os.path.join(file_dir, f) for f in os.listdir(file_dir) if f.endswith('.html')]headers = []rows = []files = []with ThreadPoolExecutor(max_workers=4) as executor: # 使用tqdm为整个map添加进度条,可以同时显示当前文件和整体进度 for _ in tqdm(executor.map(extract_data, html_files), total=len(html_files), desc='Extracting data'): pass# 处理剩余数据,并保存到CSV文件中if rows: output_file = f"out_{ datetime.now().strftime('%Y-%m-%d_%H%M%S')}_{ len(files)}.csv" write_data(output_file) files.append(output_file)# 合并所有CSV文件为一个文件output_file = f"out_{ datetime.now().strftime('%Y-%m-%d_%H%M%S')}.csv"combine_files(output_file)print(f'Data has been saved to { output_file}')执行效果:

(责任编辑:娱乐)

周一,洲际交易所(ICE)的加拿大油菜籽期货市场收盘上涨,延续数月来的上涨趋势。截至收盘,5月期约收高10.30加元,报收796.10加元/吨;7月期约收高10加元,报收755.60加元/吨;11月期

...[详细]

周一,洲际交易所(ICE)的加拿大油菜籽期货市场收盘上涨,延续数月来的上涨趋势。截至收盘,5月期约收高10.30加元,报收796.10加元/吨;7月期约收高10加元,报收755.60加元/吨;11月期

...[详细]用大数据的方式去分析基因信息,Bina Technologies获融资

用大数据的方式去分析基因信息,Bina Technologies获融资作者:佚名 2013-05-10 10:00:05云计算 今天,基因信息大数据分析服务公司Bina Technologies宣布获

...[详细]

用大数据的方式去分析基因信息,Bina Technologies获融资作者:佚名 2013-05-10 10:00:05云计算 今天,基因信息大数据分析服务公司Bina Technologies宣布获

...[详细] Metro版Firefox浏览器将至作者:萧萧 2013-08-16 14:05:10系统 Mozilla很早很早之前就开始为Windows 8开发Metro版Firefox,其进展如何?据外媒报道,

...[详细]

Metro版Firefox浏览器将至作者:萧萧 2013-08-16 14:05:10系统 Mozilla很早很早之前就开始为Windows 8开发Metro版Firefox,其进展如何?据外媒报道,

...[详细] 饮水机一般具有加热、制冷和保温功能,一些高挡饮水机还具有电泵出水和臭氧消毒功能。饮水机又称冰热水机,是一种使用瓶装水,通过机内装置加热或制冷,可以提供85~95℃热水和5~10℃冰水的饮用水设备。饮水

...[详细]

饮水机一般具有加热、制冷和保温功能,一些高挡饮水机还具有电泵出水和臭氧消毒功能。饮水机又称冰热水机,是一种使用瓶装水,通过机内装置加热或制冷,可以提供85~95℃热水和5~10℃冰水的饮用水设备。饮水

...[详细]文投控股(600715.SH):北京文创定增基金已减持17.89万股 占公司总股份的0.0096%

文投控股(600715.SH)公布,2021年2月1日,北京文创定增基金因部分基金份额持有人赎回,通过上海证券交易所集中竞价交易方式减持公司股份17.89万股,占公司总股份的0.0096%。

...[详细]

文投控股(600715.SH)公布,2021年2月1日,北京文创定增基金因部分基金份额持有人赎回,通过上海证券交易所集中竞价交易方式减持公司股份17.89万股,占公司总股份的0.0096%。

...[详细] 点心:成功是因为我们只做最懂的事原创 作者:立方 2011-09-28 09:20:44移动开发 企业动态 仅仅一年有余,点心已经由一家创新工场的孵化公司迅速成长为北京中关村知名的移动互联网企业,实

...[详细]

点心:成功是因为我们只做最懂的事原创 作者:立方 2011-09-28 09:20:44移动开发 企业动态 仅仅一年有余,点心已经由一家创新工场的孵化公司迅速成长为北京中关村知名的移动互联网企业,实

...[详细]BICS集团收购 3m Digital Networks 加速向通信平台提供商转型

BICS集团收购 3m Digital Networks 加速向通信平台提供商转型中国北京,2021年12月24日– 国际领先通信服务提供商BICS宣布,其旗下全资子公司BICS新加坡

...[详细]

BICS集团收购 3m Digital Networks 加速向通信平台提供商转型中国北京,2021年12月24日– 国际领先通信服务提供商BICS宣布,其旗下全资子公司BICS新加坡

...[详细] 对于发烧友来说,618可是一年一次抢贵价耳机的好机会。来来来,我们说道说道,你们电商节的“生日”怎么就那么多啊!一年过这么多生日,什么11.11啊,什么12.12啊..这又来了个6.18。对我这种看见

...[详细]

对于发烧友来说,618可是一年一次抢贵价耳机的好机会。来来来,我们说道说道,你们电商节的“生日”怎么就那么多啊!一年过这么多生日,什么11.11啊,什么12.12啊..这又来了个6.18。对我这种看见

...[详细]