Transformer 作为 NLP 预训练模型架构,练无能够有效的需注T相在大型未标记的数据上进行学习,研究已经证明,扩展Transformer 是到个当自 BERT 以来 NLP 任务的核心架构。

最近的成问工作表明,状态空间模型(SSM)是预训意力长范围序列建模有利的竞争架构。SSM 在语音生成和 Long Range Arena 基准上取得了 SOTA 成果,练无甚至优于 Transformer 架构。需注T相除了提高准确率之外,基于 SSM 的 routing 层也不会随着序列长度的增长而呈现二次复杂性。

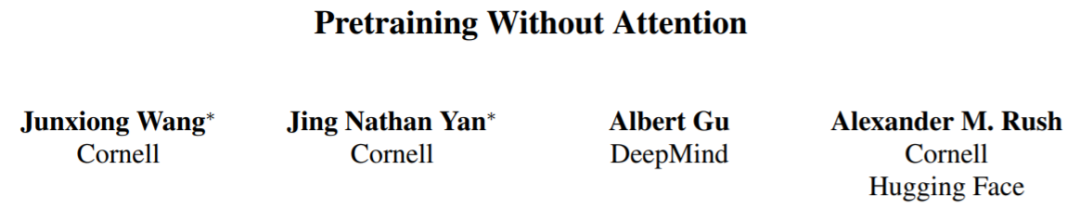

本文中,来自康奈尔大学、 DeepMind 等机构的研究者提出了双向门控 SSM (BiGS),用于无需注意力的预训练,其主要是将 SSM routing 与基于乘法门控(multiplicative gating)的架构相结合。该研究发现 SSM 本身在 NLP 的预训练中表现不佳,但集成到乘法门控架构中后,下游准确率便会提高。

实验表明,在受控设置下对相同数据进行训练,BiGS 能够与 BERT 模型的性能相匹配。通过在更长的实例上进行额外预训练,在将输入序列扩展到 4096 时,模型还能保持线性时间。分析表明,乘法门控是必要的,它修复了 SSM 模型在变长文本输入上的一些特定问题。

论文地址:https://arxiv.org/pdf/2212.10544.pdf

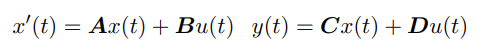

SSM 通过以下微分方程将连续输入 u (t) 与输出 y (t) 联系起来:

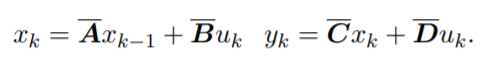

对于离散序列,SSM 参数被离散化,其过程可以近似为:

这个方程可以解释为一个线性 RNN,其中 x_k 是一个隐藏状态。y 也可以用卷积计算:

Gu 等人展示了一种在神经网络中使用 SSM 的有效方法,他们开发了参数化 A 的方法,称为 HiPPO,其产生了一个稳定而高效的架构,称为 S4。这保留了 SSM 对长期序列建模的能力,同时比 RNN 训练更有效。最近,研究人员提出了 S4 的简化对角化版本,它通过对原始参数更简单的近似实现了类似的结果。在高层次上,基于 SSM 的 routing 为神经网络中的序列建模提供了一种替代方法,而无需二次计算的注意力成本。

预训练模型架构

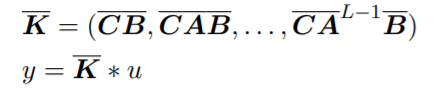

SSM 能取代预训练中的注意力吗?为了回答这个问题,该研究考虑了两种不同的架构,如图 1 所示的堆叠架构(STACK)和乘法门控架构(GATED)。

具有自注意力的堆叠架构相当于 BERT /transformer 模型,门控架构是门控单元的双向改编,最近也被用于单向 SSM。带有乘法门控的 2 个序列块(即前向和后向 SSM)夹在前馈层中。为了进行公平比较,门控架构的大小保持与堆叠架构相当。

图 1:模型变量。STACK 是标准 transformer 架构,GATED 为基于门控单元。对于 Routing 组件(虚线),该研究同时考虑双向 SSM(如图所示)和标准自注意力。门控(X)表示逐元素乘法。

预训练

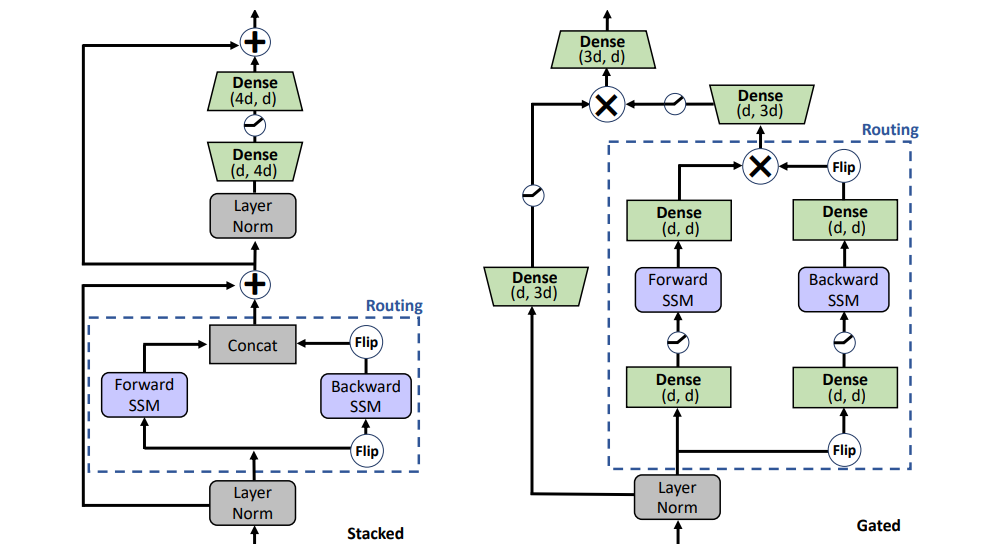

表 1 显示了 GLUE 基准测试中不同预训练模型的主要结果。BiGS 在 token 扩展上复制了 BERT 的准确率。这一结果表明,在这样的计算预算下,SSM 可以复制预训练 transformer 模型的准确率。这些结果明显优于其他基于非注意力的预训练模型。想要达到这个准确率,乘法门控是必要的。在没有门控的情况下,堆叠 SSM 的结果明显更差。为了检查这种优势是否主要来自于门控的使用,本文使用 GATE 架构训练了一个基于注意力的模型;然而,结果显示该模型的效果实际上低于 BERT。

表 1:GLUE 结果。(Top)在控制设置下,不同架构和 routing 的比较。参见图 2 了解详细信息。(Bottom) 报告了基于 CNN、LSTM 和 FNet 的其他非注意力预训练模型的可比结果。

Long-Form 任务

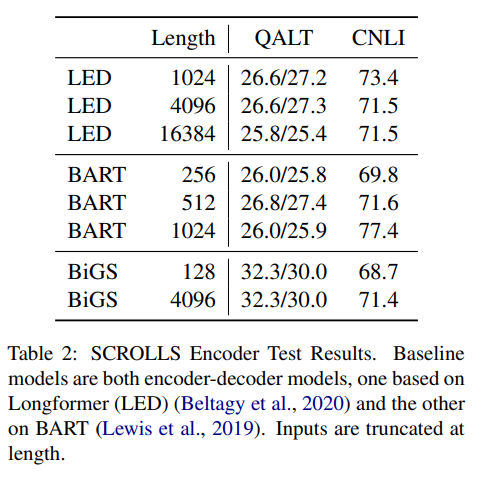

表 2 结果显示,可以将 SSM 与 Longformer EncoderDecoder (LED) 和 BART 进行比较,但是,结果显示它在远程任务中表现得也不错,甚至更胜一筹。与其他两种方法相比,SSM 的预训练数据要少得多。即使 SSM 不需要在这些长度上进行近似,长格式也依旧很重要。

表 2:SCROLLS Encoder 测试结果。基线模型都是编码器 —— 解码器模型,一个基于 Longformer (LED),另一个基于 BART。输入的长度有截断。

更多内容请查看原论文。

责任编辑:张燕妮 来源: 机器之心 模型训练(责任编辑:时尚)

在如今,少儿重疾险是比较受欢迎的,很多家长为了保障孩子的健康成长,都会购买少儿重疾险,那么少儿重疾险的最高保额是多少?少儿重疾险保额多少合适?下文就来带大家了解一下。少儿重疾险的保额一般在5~50万之

...[详细]

在如今,少儿重疾险是比较受欢迎的,很多家长为了保障孩子的健康成长,都会购买少儿重疾险,那么少儿重疾险的最高保额是多少?少儿重疾险保额多少合适?下文就来带大家了解一下。少儿重疾险的保额一般在5~50万之

...[详细] 6月1号消息,今年618第一波预售活动已经结束,小米智能生态在今天发布了618首波预售的战绩,捷报连连。6月1号消息,今年618第一波预售活动已经结束,小米智能生态在今天发布了618首波预售的战绩,捷

...[详细]

6月1号消息,今年618第一波预售活动已经结束,小米智能生态在今天发布了618首波预售的战绩,捷报连连。6月1号消息,今年618第一波预售活动已经结束,小米智能生态在今天发布了618首波预售的战绩,捷

...[详细] 微星在2023台北电脑展上展示了下一代Prestige 16系列笔记本,内置英特尔即将推出的第14代Meteor Lake处理器。微星在2023台北电脑展上展示了下一代Prestige 16系列笔记

...[详细]

微星在2023台北电脑展上展示了下一代Prestige 16系列笔记本,内置英特尔即将推出的第14代Meteor Lake处理器。微星在2023台北电脑展上展示了下一代Prestige 16系列笔记

...[详细] 眼看着一年又一年,年初年末的更换交替,心中不免思索,自己是离梦想更近一步了还是往着相反的方向渐行渐远。从笔者而言,开始于对摄影的好奇,进而是由着性子按着心情对其的摸索,到如今也能够说到比划几下,倒也是

...[详细]

眼看着一年又一年,年初年末的更换交替,心中不免思索,自己是离梦想更近一步了还是往着相反的方向渐行渐远。从笔者而言,开始于对摄影的好奇,进而是由着性子按着心情对其的摸索,到如今也能够说到比划几下,倒也是

...[详细]恒信东方(300081.SZ)公布消息:向85名激励对象授予1188万股第二类限制性股票

恒信东方(300081.SZ)公布,公司于2021年3月19日召开第七届董事会第十六次会议审议通过了《关于向2021年限制性股票激励计划激励对象首次授予限制性股票的议案》,确定以2021年3月19日为

...[详细]

恒信东方(300081.SZ)公布,公司于2021年3月19日召开第七届董事会第十六次会议审议通过了《关于向2021年限制性股票激励计划激励对象首次授予限制性股票的议案》,确定以2021年3月19日为

...[详细] 有了这些神器的帮助,你的大学生活更加丰富多彩了吧……前言幸福的假期再让人留恋也总有结束的时候,回到学校后生活上一切都得靠自己了,是不是感觉落差太大了?那就说明你一定没有准备好啊。小编这里说的“准备”不

...[详细]

有了这些神器的帮助,你的大学生活更加丰富多彩了吧……前言幸福的假期再让人留恋也总有结束的时候,回到学校后生活上一切都得靠自己了,是不是感觉落差太大了?那就说明你一定没有准备好啊。小编这里说的“准备”不

...[详细] 2月伊始,微软正式将Windows 10列为“推荐更新”,届时将有可能自动进行Windows 10更新安装。当我们正在迎接春节的时候,微软也没闲着。就在2月伊始,微软正式将Windows 10列为&l

...[详细]

2月伊始,微软正式将Windows 10列为“推荐更新”,届时将有可能自动进行Windows 10更新安装。当我们正在迎接春节的时候,微软也没闲着。就在2月伊始,微软正式将Windows 10列为&l

...[详细]比亚迪10万内唯一SUV 2023款元Pro上市9.58万元起

比亚迪2023款元Pro正式上市,官方指导价9.58万元—11.38万元。2023款元Pro基于Dragon Face 3.0设计语言打造,搭载e平台3.0技术,401KM续航里程,搭配30分钟极速快

...[详细]

比亚迪2023款元Pro正式上市,官方指导价9.58万元—11.38万元。2023款元Pro基于Dragon Face 3.0设计语言打造,搭载e平台3.0技术,401KM续航里程,搭配30分钟极速快

...[详细] 随着社会经济的不断发展,市面上的小贷机构也在不断地涌现。在这样的情况下,微众银行横空而出。很多人都没有听说过微众银行,但一定听说过它旗下的微粒贷。微众银行贷款靠谱吗?微众银行微业贷申请条件有哪些?微众

...[详细]

随着社会经济的不断发展,市面上的小贷机构也在不断地涌现。在这样的情况下,微众银行横空而出。很多人都没有听说过微众银行,但一定听说过它旗下的微粒贷。微众银行贷款靠谱吗?微众银行微业贷申请条件有哪些?微众

...[详细] 数字内容展示工具Sway随着th2发布!将来许多企业、学校和机构也能使用Sway制作和分享交互式报告、演示文稿、作业、课程、项目等等无标题文档数字内容展示工具Sway随着th2发布!将来许多企业、学校

...[详细]

数字内容展示工具Sway随着th2发布!将来许多企业、学校和机构也能使用Sway制作和分享交互式报告、演示文稿、作业、课程、项目等等无标题文档数字内容展示工具Sway随着th2发布!将来许多企业、学校

...[详细]