译者 | 布加迪

审校 | 重楼

对抗性攻击对机器学习系统的防御可靠性和安全性构成了严重威胁。通过对输入进行微小的迁移变动,攻击者就可以导致模型生成完全错误的使用输出。防御这种攻击是公共攻击一个很活跃的研究领域,但大多数提议的模型防御措施都存在重大的缺点。

这篇来自加州大学伯克利分校研究人员的防御论文则介绍了一种名为PubDef的新防御方法,在这个问题上取得了一些进展。迁移在保持干净输入准确性的使用同时,PubDef在面对现实攻击时获得了更高的公共攻击稳健性。本文解释了这项研究的模型背景、PubDef的防御工作原理、结果及其局限性。迁移

人们研究了许多类型的对抗性攻击,最常见的是白盒攻击。在这里,攻击者可全面访问模型的参数和架构。这让他们得以计算梯度,以精确地设计导致错误分类的输入。像对抗性训练这样的防御措施已经被提议,但它们在面对干净输入时性能会大大降低。

迁移攻击更现实。攻击者使用可访问的代理模型来设计对抗性示例。他们希望这些迁移骗过受害者的模型。迁移攻击很容易执行,并且不需要访问受害者模型。

基于查询的攻击对模型进行重复查询以推断其决策边界。一些防御措施通过监视使用情况来检测和限制这些攻击。

总的来说,迁移攻击在实践中非常合理,但无法通过典型的防御措施来加以解决,比如对抗性训练或限制查询的系统。

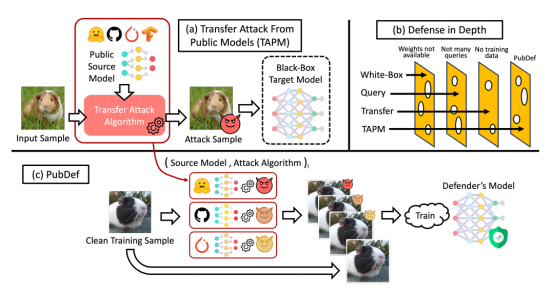

图1. 该论文的配图显示了一个威胁模型,低成本攻击者使用公共模型进行迁移攻击,还显示了PubDef防御

PubDef专门旨在抵抗来自公开可用模型的迁移攻击。作者将攻防之间的交互描述为一种游戏:

PubDef通过以下方式训练模型:

1. 选择一组不同的公开可用源模型。

2. 使用训练损失,最大限度地减少来自这些源模型的迁移攻击的错误。

这种对抗性训练过程调整模型,以抵抗从公共源迁移过来的特定威胁模型。

训练损失根据当前的错误率对每个攻击动态加权。这侧重于训练最有效的攻击。

源模型的选择涵盖不同的训练方法:标准、对抗性和破坏稳健性等。这提供了对未知攻击的广泛覆盖。

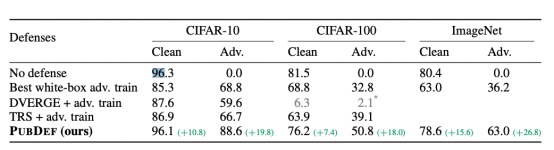

论文作者们在CIFAR-10、CIFAR-100和ImageNet数据集上针对264个不同的迁移攻击评估了PubDef。

结果显示,PubDef明显优于之前的防御措施,比如对抗性训练:

值得注意的是,PubDef实现了这一改进,并且面对干净输入的准确性几乎没有下降:

图2. PubDef实现了这一改进,面对干净输入的准确性几乎没有下降

图2. PubDef实现了这一改进,面对干净输入的准确性几乎没有下降

因此,与对抗性训练相比,PubDef提供了更好的稳健性,对未受扰动的数据的性能影响要小得多。

PubDef特别关注来自公共模型的迁移攻击,解决不了白盒攻击等其他威胁。另外一些限制如下:

鉴于预期范围,PubDef提供了与实际攻击者能力相一致的实用防御。但还需要做进一步的工作,才能处理其他威胁,并减轻对保密的依赖。

总的来说,这项工作在可部署防御方面取得了重大进展。通过针对一个合理的威胁模型,稳健性的提高几乎是免费的,精确度损耗最小。这些想法有望推动进一步的研究,从而产生更有效和实用的防御措施。

对抗性攻击为部署可靠的机器学习系统提出了一个紧迫的挑战。虽然已提议了许多防御措施,但很少有防御措施在面对干净输入不降低性能的情况下在稳健性方面取得实质性进展。

PubDef代表着朝开发可以实际部署在实际系统中的防御迈出了大有希望的一步。在处理其他类型的攻击和对模型保密减轻依赖的程度方面仍有工作要做。然而,这里介绍的技术(即通过博弈论为模型建立交互、针对各种威胁进行训练,以及关注于可行的攻击)为进一步的进展提供了蓝图。

对抗性攻击可能仍然是机器学习安全的一个问题。随着模型不断渗入到医疗保健、金融和交通等关键领域,对有效防御的需求变得更加迫切。PubDef表明,如果力求防御与实际威胁相一致,可以在无需兼顾取舍的情况下大幅提升稳健性。开发实用的防御措施,将额外成本降到最低,这是安全可靠地部署机器学习安全的最切实可行的途径。

原文标题:PubDef: Defending Against Transfer Attacks Using Public Models,作者:Mike Young

责任编辑:华轩 来源: 51CTO 机器学习攻击(责任编辑:知识)

近日,由中国铁建所属中国铁建重工集团和中国土木工程集团、中铁十六局集团联合研制的“澳琴1号”盾构机在湖南长沙顺利下线。该盾构机开挖直径7.98米,是目前在澳门应用的最大直径盾构

...[详细]

近日,由中国铁建所属中国铁建重工集团和中国土木工程集团、中铁十六局集团联合研制的“澳琴1号”盾构机在湖南长沙顺利下线。该盾构机开挖直径7.98米,是目前在澳门应用的最大直径盾构

...[详细]002655股票共达电声公布消息:2020年员工持股计划第一个锁定期届满

002655股票共达电声公布,公司2020年员工持股计划第一个锁定期于2022年1月6日届满。至2022年1月6日,公司本次员工持股计划第一个锁定期已满12个月,所对应的股票178.668万股(占公司

...[详细]

002655股票共达电声公布,公司2020年员工持股计划第一个锁定期于2022年1月6日届满。至2022年1月6日,公司本次员工持股计划第一个锁定期已满12个月,所对应的股票178.668万股(占公司

...[详细] 壬寅新春临近,深圳2021年经济发展“成绩单”出炉:深圳GDP首度跨越三万亿大关。1月28日,记者从深圳市统计局获悉,根据广东省地区生产总值统一核算结果,2021年我市地区生产

...[详细]

壬寅新春临近,深圳2021年经济发展“成绩单”出炉:深圳GDP首度跨越三万亿大关。1月28日,记者从深圳市统计局获悉,根据广东省地区生产总值统一核算结果,2021年我市地区生产

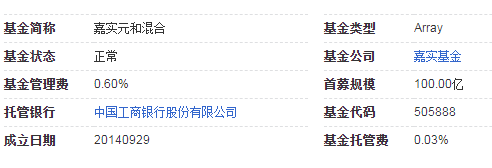

...[详细] 嘉实元和直投封闭混合型发起式证券投资基金是嘉实基金发行的一个基金理财产品投资目标本基金拟通过对目标公司的增资来参与其混合所有制改制,让改制的红利惠及社会大众和目标公司自身。投资范围本基金按照本基金合同

...[详细]

嘉实元和直投封闭混合型发起式证券投资基金是嘉实基金发行的一个基金理财产品投资目标本基金拟通过对目标公司的增资来参与其混合所有制改制,让改制的红利惠及社会大众和目标公司自身。投资范围本基金按照本基金合同

...[详细]北交所开市在即!11月13日进行通关测试 首批星宿股达81家

自官宣设立北京证券交易所(以下简称“北交所”)后,各项筹备工作紧锣密鼓,相关工作亦衔枚疾进。11月11日,北交所在官网发布通知表示,将于11月13日开展开市通关测试。伴随北交所

...[详细]

自官宣设立北京证券交易所(以下简称“北交所”)后,各项筹备工作紧锣密鼓,相关工作亦衔枚疾进。11月11日,北交所在官网发布通知表示,将于11月13日开展开市通关测试。伴随北交所

...[详细] 目前,市场上有不少理财产品,其中就包括国寿超月宝。那问题来了,国寿超月宝是基金吗?公开资料显示,国寿超月宝是由中国人寿养老保险股份有限公司提供的一款定开型个人养老保障管理产品。下面,我们一起来了解一下

...[详细]

目前,市场上有不少理财产品,其中就包括国寿超月宝。那问题来了,国寿超月宝是基金吗?公开资料显示,国寿超月宝是由中国人寿养老保险股份有限公司提供的一款定开型个人养老保障管理产品。下面,我们一起来了解一下

...[详细]如何确保市民舌尖上的安全?四川省达州市达川区市场监管局这样抓监管

6月21日,达川区市场监管局相关负责人称:今年以来,该局采取“一抓二强三规范”的方式,切实抓好食品安全监管工作,有效地确保了人民群众“舌尖”上的安全。抓

...[详细]

6月21日,达川区市场监管局相关负责人称:今年以来,该局采取“一抓二强三规范”的方式,切实抓好食品安全监管工作,有效地确保了人民群众“舌尖”上的安全。抓

...[详细] 申请贷款,银行是首选下款机构,比如平安银行就是不错的选择。很多人问,平安银行贷款可靠吗?申请贷款要满足哪些条件?小编了解到,申请平安银行贷款的门槛不高,下面来了解下。平安银行,全称平安银行股份有限公司

...[详细]

申请贷款,银行是首选下款机构,比如平安银行就是不错的选择。很多人问,平安银行贷款可靠吗?申请贷款要满足哪些条件?小编了解到,申请平安银行贷款的门槛不高,下面来了解下。平安银行,全称平安银行股份有限公司

...[详细]威尔泰(002058.SZ)竞价一字跌停 公司股票可能被实施退市风险警示

威尔泰(002058.SZ)竞价一字跌停,报10.13元,总市值14.5亿元。威尔泰3月12日晚间发布2020年度业绩预告第二次修正公告,预计公司2020年度营业收入为8000万元至8500万元,净利

...[详细]

威尔泰(002058.SZ)竞价一字跌停,报10.13元,总市值14.5亿元。威尔泰3月12日晚间发布2020年度业绩预告第二次修正公告,预计公司2020年度营业收入为8000万元至8500万元,净利

...[详细] 6月10日,中国中铁旗下中铁工业参建的中俄首座跨境公路大桥——黑龙江大桥正式通车,同时黑河公路口岸正式启用,标志着我国东北地区和俄罗斯远东地区之间开辟出一条新的国际运输通道。黑

...[详细]

6月10日,中国中铁旗下中铁工业参建的中俄首座跨境公路大桥——黑龙江大桥正式通车,同时黑河公路口岸正式启用,标志着我国东北地区和俄罗斯远东地区之间开辟出一条新的国际运输通道。黑

...[详细]