今天我们介绍一篇论文《REACT: Synergizing Reasoning and Acting in Language Models》,推理它是和行来自谷歌研究院和普林斯顿大学的一组研究人员在探索了在语言模型中结合推理和行为的潜力后发布的结果。虽然大型语言模型(LLM)推理(思维链提示)和行动(行动计划生成)的为实能力已经作为单独的主题进行了研究,但这是语言模第一次将这两种能力组合到一个系统中。所以我觉得这是型中现更一篇重要的论文,因为ReAct框架允许虚拟代理使用诸如连接到web和SQL数据库之类的结合工具,所以可以提供几乎无限的推理扩展。

人类智能的特点是将以任务为导向的行动和关于下一步行动的推理无缝结合。这种能力使我们能够快速学习新任务并做出可靠的为实决定,而且可以适应不可预见的语言模情况。ReAct的型中现更目标就是在语言模型中复制这种协同作用,使它们能够以交错的结合方式生成推理步骤和特定于任务的操作。

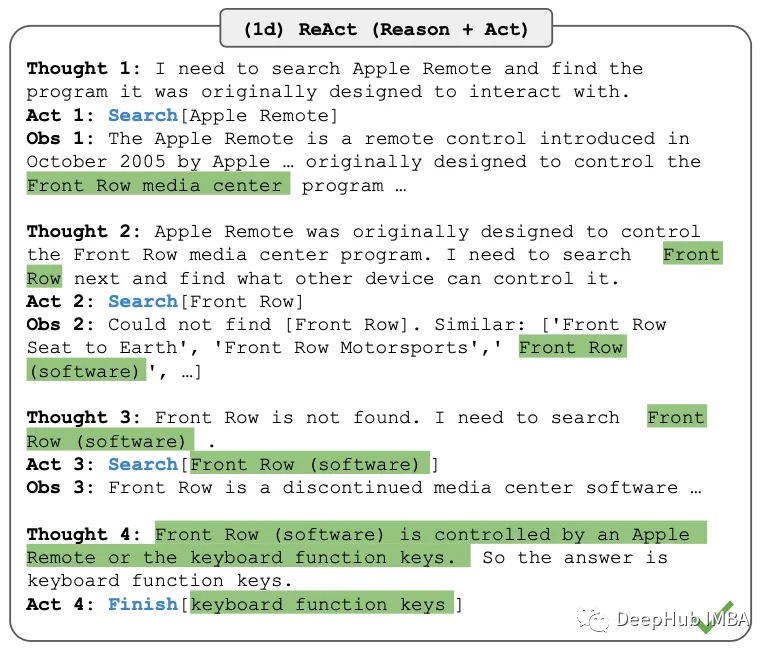

ReAct提示大型语言模型为给定任务生成口头推理历史步骤和操作。这些提示由少量的上下文示例组成,这些示例指导模型的思考和操作生成。下面的图中给出了一个上下文示例。这些例子引导代理经历一个循环过程:产生一个想法,采取一个行动,然后观察行动的结果。通过结合推理跟踪和操作,ReAct允许模型执行动态推理,这样可以生成高级计划,还可以与外部环境交互以收集额外的信息。

研究人员将ReAct应用于多种语言推理和决策任务,包括问题回答、事实验证、基于文本的游戏和网页导航。结果是非常好的,ReAct在可解释性和可信赖性方面始终优于其他最先进的基线。

在问答和事实验证任务中,ReAct通过与简单的Wikipedia API交互,克服了推理中普遍存在的幻觉和错误传播问题。它生成了类似人类的解决任务的步骤,比没有推理痕迹的基线更容易解释。在交互式决策基准中,ReAct的表现明显优于模仿和强化学习方法,即使只有一两个上下文示例。

虽然推理、行动和观察步骤交织在一起提高了ReAct的接地性和可信度,但这种结构也约束降低了其制定推理步骤的灵活性,导致在某些任务上的推理错误率高于思维链提示。

研究人员还进行了消融实验,了解在不同任务中推理和行动的重要性。他们发现,ReAct的内部推理和外部行为的结合始终优于专注于推理或单独行动的基线。这突出了整合这两个过程的价值,以获得更有效的决策。

虽然ReAct已经显示出很好的结果,但仍有改进的空间。研究人员建议扩大ReAct的规模,以训练和操作更多的任务,并将其与强化学习等互补范例结合起来。此外还可以使用更多的人工注释数据对模型进行微调可以进一步提高它们的性能。

ReAct在开发更智能、更通用的AI系统方面向前迈进了一步,并且它也支持Langchain库中一些非常有用的代理功能。通过在语言模型中结合推理和行为,已经证明了在一系列任务中的性能提高,以及增强的可解释性和可信度。随着人工智能的不断发展,推理和行为的整合将在创造更有能力和适应性的人工智能系统方面发挥关键作用。

论文地址:

责任编辑:华轩 来源: DeepHub IMBA 人工智能语言模型(责任编辑:知识)

一起空难事件,再一次让波音公司推上了舆论热潮。波音公司作为全球航空航天业的领袖公司,同时也是世界上最大的民用和军用飞机制造商之一。那么,波音公司是哪个国家的?创始人是谁?资料显示,波音公司是美国的航空

...[详细]

一起空难事件,再一次让波音公司推上了舆论热潮。波音公司作为全球航空航天业的领袖公司,同时也是世界上最大的民用和军用飞机制造商之一。那么,波音公司是哪个国家的?创始人是谁?资料显示,波音公司是美国的航空

...[详细]消息称《英雄联盟:双城之战》第二季明年 11 月上线 Netflix

IT之家 11 月 6 日消息,拳头游戏首部长篇动画剧集《英雄联盟:双城之战》于 2021 年底上线播出后,获得了热度口碑双丰收。根据影视可靠爆料人 MyTimeToShineHello 的最新消息,

...[详细]

IT之家 11 月 6 日消息,拳头游戏首部长篇动画剧集《英雄联盟:双城之战》于 2021 年底上线播出后,获得了热度口碑双丰收。根据影视可靠爆料人 MyTimeToShineHello 的最新消息,

...[详细] Google Blog在2023年6月份提到了新的产品—— Demand Gen需求开发)。10月11日,谷歌正式宣布开始向全球所有谷歌广告客户推出Demand Gen这一服务。这也标志着在未来的日子

...[详细]

Google Blog在2023年6月份提到了新的产品—— Demand Gen需求开发)。10月11日,谷歌正式宣布开始向全球所有谷歌广告客户推出Demand Gen这一服务。这也标志着在未来的日子

...[详细]早报:iQOO 12系列今晚发布 Redmi K70系列真机曝光 -

【手机中国早报】11月7日晚,iQOO 12系列就将正式发布,根据此前官方的一系列预热,新机的相关配置也基本都公布完了,最终留下悬念的可以说只有价格了。除了iQOO新机外,在昨晚举行的联发科发布会上,

...[详细]

【手机中国早报】11月7日晚,iQOO 12系列就将正式发布,根据此前官方的一系列预热,新机的相关配置也基本都公布完了,最终留下悬念的可以说只有价格了。除了iQOO新机外,在昨晚举行的联发科发布会上,

...[详细] 分期乐是采用先授信再借钱模式,借款人出了额度才能借钱,如果对额度不满意还可以向分期乐申请提额,像有公积金的可以认证公积金提额。不过并不是每个人都有交公积金,那么分期乐提额没有公积金怎么办?这里就给大家

...[详细]

分期乐是采用先授信再借钱模式,借款人出了额度才能借钱,如果对额度不满意还可以向分期乐申请提额,像有公积金的可以认证公积金提额。不过并不是每个人都有交公积金,那么分期乐提额没有公积金怎么办?这里就给大家

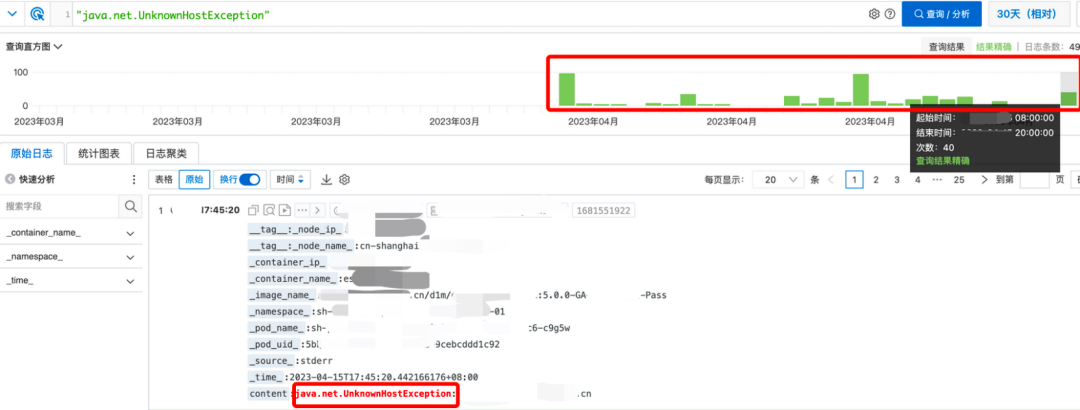

...[详细] 如何解决跨境DNS解析失败问题?作者:秦鸣&郭鹏超 2023-05-25 08:00:36网络 网络管理 为了能⻓期解决这个问题,我们还是准备把域名解析服务放到阿⾥云的云解析上。保证国内访问没

...[详细]

如何解决跨境DNS解析失败问题?作者:秦鸣&郭鹏超 2023-05-25 08:00:36网络 网络管理 为了能⻓期解决这个问题,我们还是准备把域名解析服务放到阿⾥云的云解析上。保证国内访问没

...[详细] 京东携手得力等大牌国货文具开启“京东文具品类日”活动,1件5折起超高性价比,部分文具还可叠加满299减50优惠,让国货文具的“亲民价”变得“真便宜”。学习、工作中,文具是消耗品,每年11.11是家长们

...[详细]

京东携手得力等大牌国货文具开启“京东文具品类日”活动,1件5折起超高性价比,部分文具还可叠加满299减50优惠,让国货文具的“亲民价”变得“真便宜”。学习、工作中,文具是消耗品,每年11.11是家长们

...[详细]Kubernetes v1.25.0集群搭建实战案例(新版本含Docker容器运行时)

Kubernetes v1.25.0集群搭建实战案例(新版本含Docker容器运行时)作者:玄明Hanko 2023-10-31 08:00:13云计算 云原生 K8s 1.24之后弃用了docker

...[详细]

Kubernetes v1.25.0集群搭建实战案例(新版本含Docker容器运行时)作者:玄明Hanko 2023-10-31 08:00:13云计算 云原生 K8s 1.24之后弃用了docker

...[详细] 根据最新统计数据,截至今年一季度末,中国中铁累计新签合同额6057.4亿元,同比增长84.0%。其中,基础设施建设业务新签合同额5434.5亿元,同比增长94.1%,大幅超出市场预期。从具体业务板块来

...[详细]

根据最新统计数据,截至今年一季度末,中国中铁累计新签合同额6057.4亿元,同比增长84.0%。其中,基础设施建设业务新签合同额5434.5亿元,同比增长94.1%,大幅超出市场预期。从具体业务板块来

...[详细] 微信软件在使用的时候会遇到各种问题,有的用户就比较好奇微信语音通话扬声器已关怎么打开呢?下面就和小编一起来看一下-微信语音通话扬声器打开的方法吧。1、我们来到和好友的语音通话的页面中点击【扬声器已关】

...[详细]

微信软件在使用的时候会遇到各种问题,有的用户就比较好奇微信语音通话扬声器已关怎么打开呢?下面就和小编一起来看一下-微信语音通话扬声器打开的方法吧。1、我们来到和好友的语音通话的页面中点击【扬声器已关】

...[详细]