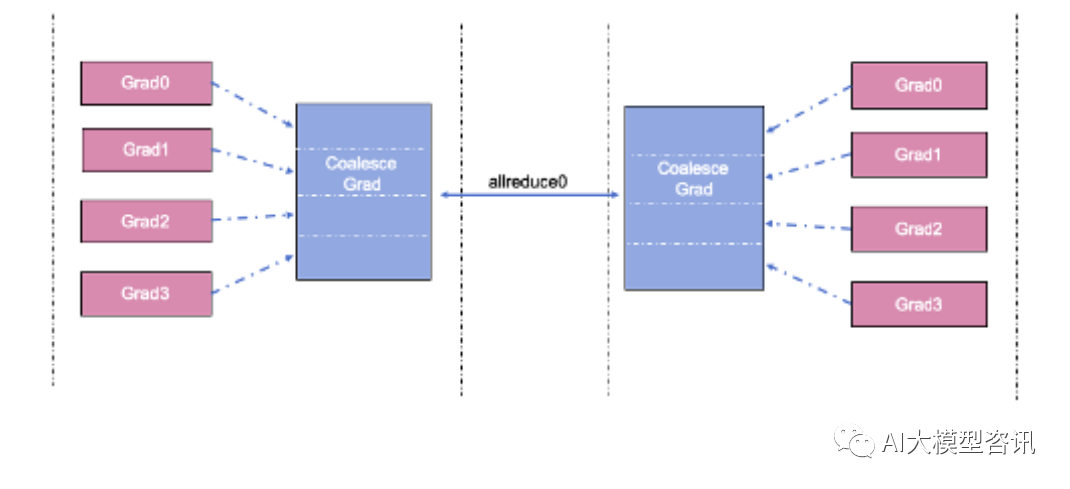

从上文知道数据并行中需要同步每一个模型梯度,布式并行 这是技术通过进程间的 Allreduce 通信实现的。如果一个模型 有非常多的大模参数,则数据并行训练的型分每一个 step 中会有非常多次的 Allreduce 通信,下图为融合梯度同步示例。布式并行

融合梯度同步示例

融合梯度同步示例

通信的技术耗时可以从通信延迟(lantency) 和数据传输时间消耗两方面考虑。单次通信延迟时间相对固定,大模 而 传输时间由通信的型分数据量和带宽决定。减少总的布式并行通信消耗, 可以通过减少通信频率来实现, 通信融合是一个可 行的手段,通过将 N 个梯度的 Allreduce 通信合并成一次 Allreduce 通信,可以减少 N- 1 次通信延迟时间。

常用的 Allreduce 融合实现方式是在通信前将多个梯度 tensors 拼接成一个内存地址连续的大 tensor,梯度同 步时仅对拼接后的大 tensor 做一次 Allreduce 操作。参数更新时将大 tensor 切分还原回之前的多个小 tensors,完 成每个梯度对应参数的更新。

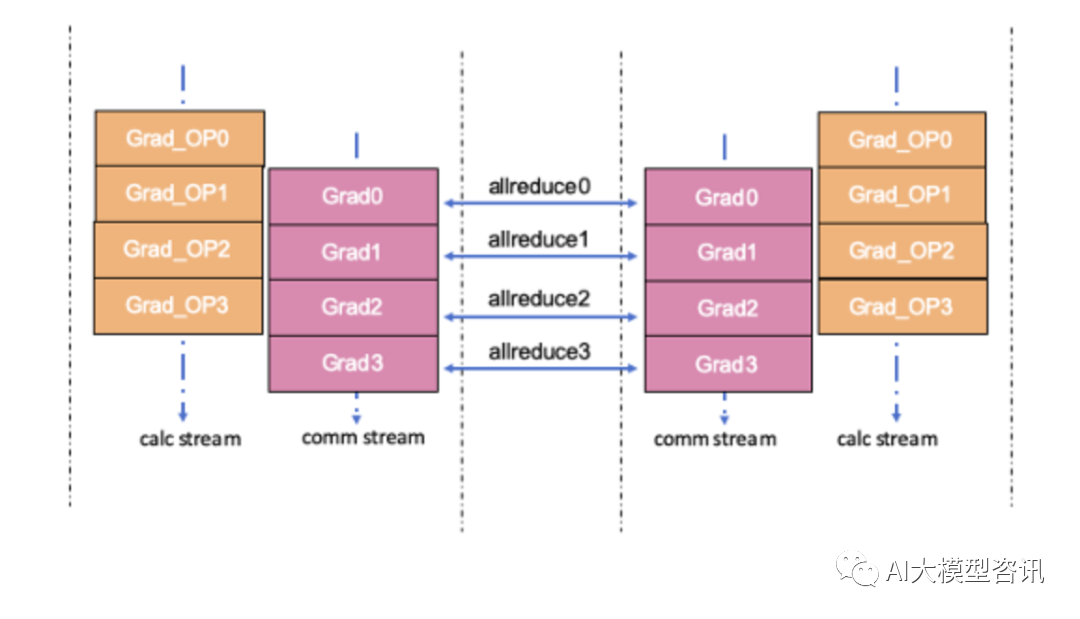

除了降低绝对的通信耗时,还可以从降低整体训练耗时角度来优化,可以考虑通信和计算的异步流水实现。 数据并行中的梯度同步 Allreduce 通信是在训练的反向过程中进行的, 而 Allreduce 后得到的同步梯度是在训练 的更新过程中才被使用, 在反向中并没有被使用。也就是说上一个梯度的通信和下一个梯度的计算间并没有依 赖,通信和计算可以并行,让两者的耗时相互重叠掩盖,减少反向的耗时,下图为通信计算并行相互重叠示例。

通信计算并行相互重叠示例。

通信计算并行相互重叠示例。

通信和计算的重叠通常是将通信和计算算子调度到不同的流 (stream) 上实现的。通信算子调度到通信流, 计 算算子调度到计算流, 同一个流上的算子间是顺序执行的, 不同流上的算子可以并行执行, 从而实现反向中梯 度通信和计算的并行重叠。需要注意的是, 当通信和计算被调度在不同的流上执行时, 需要考虑两个流之间依 赖和同步关系。

在梯度同步的数据并行场景中,开发者需要需要通过 stream 间的同步功能保证:

以上两个方法是数据并行中常用的减少通信时间消耗, 提高并行加速比的优化策略。如果能做到通信和计 算的重叠程度越高,那么数据并行的加速比越接近 100% ,多卡并行对训练吞吐提升的效率也就越高。

责任编辑:武晓燕 来源: AI大模型咨讯 分布式并行技术(责任编辑:综合)

京东是一个非常注重品质和送货速度的购物平台,为了满足用户的消费需求,京东也推出了京东白条、京东金条等服务,京东白条主要为用户购物时提供先消费后付款的支付服务,而京东金条就类似于支付宝借呗、微信微粒贷了

...[详细]

京东是一个非常注重品质和送货速度的购物平台,为了满足用户的消费需求,京东也推出了京东白条、京东金条等服务,京东白条主要为用户购物时提供先消费后付款的支付服务,而京东金条就类似于支付宝借呗、微信微粒贷了

...[详细] 在使用U盘的过程中,经常发现U盘处于写保护状态,影响了使用。网上虽然提供了一些方法,但总体而言并不简单,很多涉及到修改注册表或者通过U盘量产工具进行操作,设置比较复杂,甚至还可能破坏U盘,导致U盘无法

...[详细]

在使用U盘的过程中,经常发现U盘处于写保护状态,影响了使用。网上虽然提供了一些方法,但总体而言并不简单,很多涉及到修改注册表或者通过U盘量产工具进行操作,设置比较复杂,甚至还可能破坏U盘,导致U盘无法

...[详细] Windows 11按理说应该是Windows 12?但这次好像不太一样。据多个消息源确认,Windows的下一个重大版本将不会是Windows 11的直接升级版,而是更专注于云和Web,同时大力接入

...[详细]

Windows 11按理说应该是Windows 12?但这次好像不太一样。据多个消息源确认,Windows的下一个重大版本将不会是Windows 11的直接升级版,而是更专注于云和Web,同时大力接入

...[详细] 通过扩展logback日志来发送异常信息邮件作者:IT学习道场 2022-07-08 09:01:36运维 系统运维 这篇是通过扩展 logback 的日志插件来处理 err 级别的日志异常信息来发送

...[详细]

通过扩展logback日志来发送异常信息邮件作者:IT学习道场 2022-07-08 09:01:36运维 系统运维 这篇是通过扩展 logback 的日志插件来处理 err 级别的日志异常信息来发送

...[详细] 2022年一季度,中盐集团实现营业收入同比增长48.8%,利润总额同比增长163.0%,净利润同比增长163.3%,再创历史新高,其他指标稳中向好、增速明显,“四利两率”全面优

...[详细]

2022年一季度,中盐集团实现营业收入同比增长48.8%,利润总额同比增长163.0%,净利润同比增长163.3%,再创历史新高,其他指标稳中向好、增速明显,“四利两率”全面优

...[详细] VOI桌面虚拟化的模式创新作者:佚名 2016-02-19 09:26:26云计算 虚拟化 如今许多企业在部署虚拟桌面基础设施(VDI),以实现单一镜像管理,期待实现灵活的桌面交付及简捷的终端管理,同

...[详细]

VOI桌面虚拟化的模式创新作者:佚名 2016-02-19 09:26:26云计算 虚拟化 如今许多企业在部署虚拟桌面基础设施(VDI),以实现单一镜像管理,期待实现灵活的桌面交付及简捷的终端管理,同

...[详细] 超频三推出了星界C3 T500海景房机箱,提供了黑白两种配色,而且支持背插主板安装。超频三推出了星界C3 T500海景房机箱,提供了黑色和白色两种配色可选,采用了双玻璃270°全视野、无立柱和快拆设计

...[详细]

超频三推出了星界C3 T500海景房机箱,提供了黑白两种配色,而且支持背插主板安装。超频三推出了星界C3 T500海景房机箱,提供了黑色和白色两种配色可选,采用了双玻璃270°全视野、无立柱和快拆设计

...[详细] 超频三推出了星界C3 T500海景房机箱,提供了黑白两种配色,而且支持背插主板安装。超频三推出了星界C3 T500海景房机箱,提供了黑色和白色两种配色可选,采用了双玻璃270°全视野、无立柱和快拆设计

...[详细]

超频三推出了星界C3 T500海景房机箱,提供了黑白两种配色,而且支持背插主板安装。超频三推出了星界C3 T500海景房机箱,提供了黑色和白色两种配色可选,采用了双玻璃270°全视野、无立柱和快拆设计

...[详细] 近日,中国中铁旗下中铁工业研制的世界首台桩梁一体智能造桥机“共工号”投入使用,在深(圳)汕(尾)高速公路西段改扩建工程梅陇特大桥顺利完成10跨作业,实现了工厂化预制、精益化管理

...[详细]

近日,中国中铁旗下中铁工业研制的世界首台桩梁一体智能造桥机“共工号”投入使用,在深(圳)汕(尾)高速公路西段改扩建工程梅陇特大桥顺利完成10跨作业,实现了工厂化预制、精益化管理

...[详细] 提高应用程序性能的7个DevOps实践译文 作者: 黄显东 2022-07-04 17:32:12运维 DevOps 是

...[详细]

提高应用程序性能的7个DevOps实践译文 作者: 黄显东 2022-07-04 17:32:12运维 DevOps 是

...[详细]