2013年4月26日-27日,服务由51CTO传媒集团旗下WOT(World Of Tech)品牌主办的平台2013大数据全球技术峰会在北京富力万丽酒店召开。本次峰会将围绕大数据基础架构与上层应用的罗李生态系统,解决大规模数据引发的基于问题,探索大数据基础的数据解决方案,激发数据挖掘带来的服务竞争力,让数据发出声音。平台51CTO作为本次峰会的主办方,将全程视频、图文直播报道这场数据的盛宴,更多内容请点击专题:2013大数据全球技术峰会。

2013大数据全球技术峰会专题

[[71730]]

来自于阿里巴巴集团分布式团队成员罗李与在场观众分享,阿里的大数据发展经历几个阶段。

首先是单机版。但是面临着容量问题,一台机器放不下怎么办?同时单机的性能也不能达到要求。

之后阿里用了市面上流行的分布式数据库方案,容量和计算能力比单机版翻了好几倍,当时满足淘宝和阿里巴巴业务的发展。但发展到一定程度后,这种方式的问题初见端倪,首先容量有限制,作为一款商业软件,它的价格不菲,按照容量收费导致软件越用越贵。同时在大数据场景下,系统的稳定性也不是特别好。

再后来阿里内部有一些部门开始使用Hadoop,08年时阿里拥有7-8个大大小小的Hadoop集群,从十几台到一两百台,基本用于处理离线数据处理。但各个集群都各自为政独立发展,却又有千丝万缕的联系,虽相互依赖,但集群规模和运行水平却参差不齐,所以集群的稳定性一直是一个问题,***的问题就是集群重复建设,高成本,低效率。

那么什么才是适合阿里巴巴的大数据解决方案?

云梯Hadoop服务集群

• HDFS - 海量数据存储服务

• 分组,通过quota(空间/文件数)限制:/group/taobao

• 数据共享:淘宝/天猫/一淘/B2B/支付宝

• MapReduce - 大规模分布式计算服务

• 分组,slot限制,按需申请,集中分配和调度

• 生产 / 开发 / 测试共享集群,白天开发,晚上生产

• 服务特色

• 单一大集群

• 多用户共享

• 计算分时

• 资源按需申请,按使用量计费

Hadoop最重要的两项服务是HDFS和MapReduce,阿里通过分组对资源做了切分,HDFS通过文件数和空间的配额做限制,mapreduce是做slot的限制。数据可以在阿里的平台上方便的共享,计算资源通过分时共享,白天进行开发和测试任务,晚上进行生产任务。

云梯提供的其他Hadoop服务有哪些?

其实这些服务都来自于Hadoop开源生态圈,并且可以很方便的吸收进来,这就是使用开源软件的优势。

最重要的服务是Hive,如果要迁移oracle的任务,就必须提供SQL语法的支持,hive做到了。之后阿里平台发展壮大也主要是hive的功劳,现在阿里平台上80%以上的作业是hive的。同时还提供了streaming,mahout,pig等工具。

阿里的HBase服务区别于独立的HBase集群,hbase机器和云梯其他slave机器是共享的,和其他的Mapreduce任务共享一个HDFS,阿里期望在云梯大规模数据和计算能力背景下,吸收HBase存储服务的特色,为云梯用户提供更好的在线服务体验。

[[71731]]

结尾:以上是51CTO.com记者从一线为您带来的精彩报道。后续我们还有更加精彩的独家报道,敬请关注。

责任编辑:王程程 来源: 51CTO 大数据全球技术峰会阿里淘宝(责任编辑:知识)

11月15日,国新办举行新闻发布会介绍2021年10月份国民经济运行情况,国家统计局新闻发言人、国民经济综合统计司司长付凌晖介绍,10月份,经济运行总体平稳持续恢复,农业增产在望,工业增速回升,高技术

...[详细]

11月15日,国新办举行新闻发布会介绍2021年10月份国民经济运行情况,国家统计局新闻发言人、国民经济综合统计司司长付凌晖介绍,10月份,经济运行总体平稳持续恢复,农业增产在望,工业增速回升,高技术

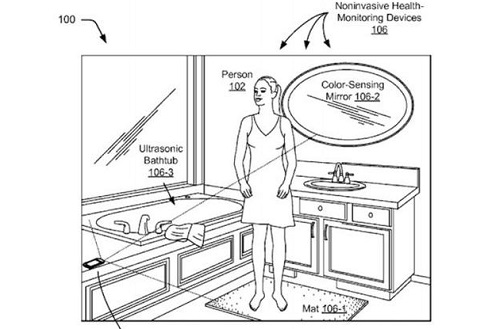

...[详细] 据Digital Trends网站报道,谷歌一直以来都在智能家居领域做着领先的尝试和努力。这其中就包括盥洗室。近日,谷歌申请的一项专利显示,可以帮助用户在家中的洗手间中随时监测自己的健康状况,通过在盥

...[详细]

据Digital Trends网站报道,谷歌一直以来都在智能家居领域做着领先的尝试和努力。这其中就包括盥洗室。近日,谷歌申请的一项专利显示,可以帮助用户在家中的洗手间中随时监测自己的健康状况,通过在盥

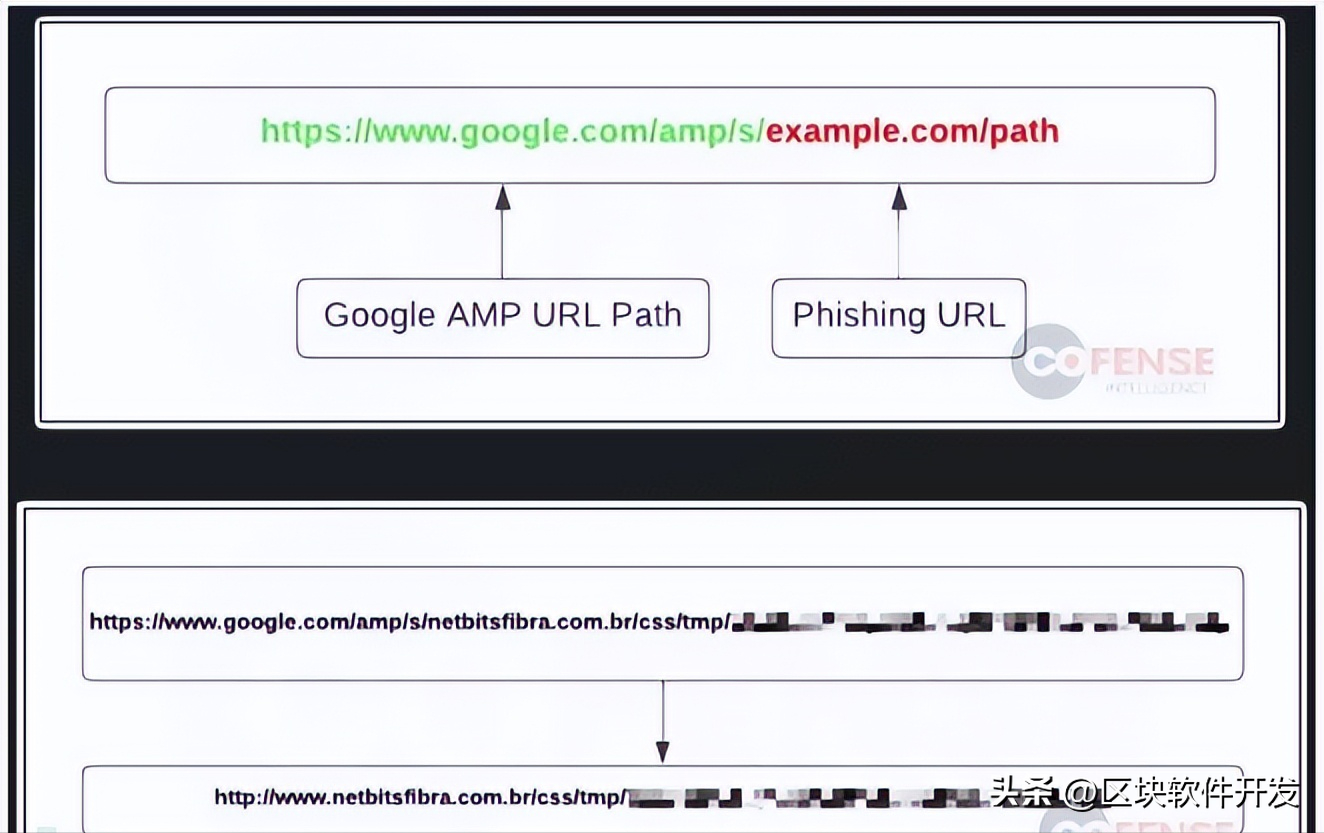

...[详细] 黑客滥用 Google AMP 进行规避性网络钓鱼攻击作者:区块软件开发 2023-08-07 15:43:55安全 应用安全 近日,有安全研究人员警告称,有越来越多的网络钓鱼活动利用谷歌加速移动页面

...[详细]

黑客滥用 Google AMP 进行规避性网络钓鱼攻击作者:区块软件开发 2023-08-07 15:43:55安全 应用安全 近日,有安全研究人员警告称,有越来越多的网络钓鱼活动利用谷歌加速移动页面

...[详细] 没想到吧!网络骗子也会上当受骗译文 精选 作者: 刘涛 2023-08-10 08:00:00安全 应用安全 自从人们开始

...[详细]

没想到吧!网络骗子也会上当受骗译文 精选 作者: 刘涛 2023-08-10 08:00:00安全 应用安全 自从人们开始

...[详细]力合微(688589.SH)2020年归母净利2782.05万元 基本每股收益0.33元

力合微(688589.SH)公告,2020年营业收入2.16亿元,同比减少22.09%;归属于上市公司股东净利润2782.05万元,同比减少35.98%;基本每股收益0.33元。公司拟每10股派发现金

...[详细]

力合微(688589.SH)公告,2020年营业收入2.16亿元,同比减少22.09%;归属于上市公司股东净利润2782.05万元,同比减少35.98%;基本每股收益0.33元。公司拟每10股派发现金

...[详细] 8月11日消息,智慧红酒信息平台酒咔嚓宣布获得海尔集团战略投资,合作运营整体规模达到1000万美元,并携手推出智慧酒柜“启源”。据了解,酒咔嚓于曾获得PreAngel种子轮投资,2013年1月获得老鹰

...[详细]

8月11日消息,智慧红酒信息平台酒咔嚓宣布获得海尔集团战略投资,合作运营整体规模达到1000万美元,并携手推出智慧酒柜“启源”。据了解,酒咔嚓于曾获得PreAngel种子轮投资,2013年1月获得老鹰

...[详细] 8月12日消息,微信开发者平台很快正式宣布邀请音乐人胡海泉出任首席内容官一职,胡海泉也通过微博发文。据创投时报项目库数据显示,很快隶属于天津将至网络技术有限公司 ,成立于2015年,以服务微信开发者为

...[详细]

8月12日消息,微信开发者平台很快正式宣布邀请音乐人胡海泉出任首席内容官一职,胡海泉也通过微博发文。据创投时报项目库数据显示,很快隶属于天津将至网络技术有限公司 ,成立于2015年,以服务微信开发者为

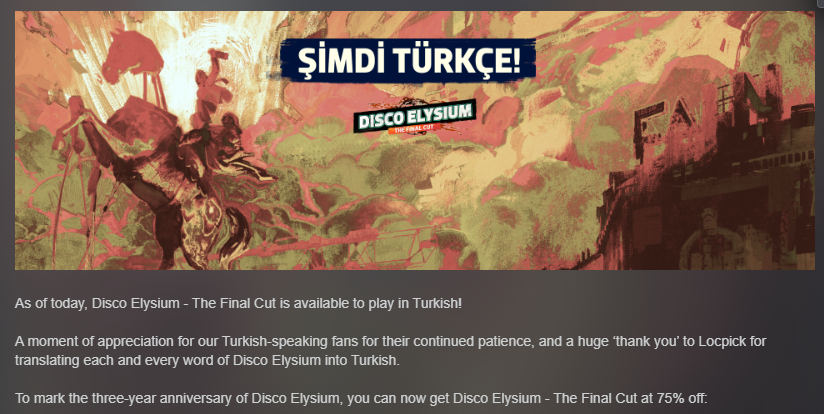

...[详细] 为庆祝色扮演类游戏《极乐迪斯科》Disco Elysium)发售3周年,游戏官方在Steam商城开启优惠活动,《极乐迪斯科:最终剪辑版》折后仅需29元,优惠截止至11月8日。游戏Steam页面:点击此

...[详细]

为庆祝色扮演类游戏《极乐迪斯科》Disco Elysium)发售3周年,游戏官方在Steam商城开启优惠活动,《极乐迪斯科:最终剪辑版》折后仅需29元,优惠截止至11月8日。游戏Steam页面:点击此

...[详细]东方空间完成4亿元A轮融资 老股东鼎和高达、天府三江资本等机构持续加持

5月20日,东方空间(山东)科技有限公司宣布完成4亿元人民币A轮融资。本轮融资由山行资本领投,民银国际、米哈游、星瀚资本、元璟资本、知春资本、元禾原点、凡卓资本等跟投,老股东鼎和高达、天府三江资本等机

...[详细]

5月20日,东方空间(山东)科技有限公司宣布完成4亿元人民币A轮融资。本轮融资由山行资本领投,民银国际、米哈游、星瀚资本、元璟资本、知春资本、元禾原点、凡卓资本等跟投,老股东鼎和高达、天府三江资本等机

...[详细]拿地十年的杭州港龙悠乐城将于1月6日正式开业 建筑面积23万平

1月4日,观点新媒体了解到,杭州港龙悠乐城原杭州港龙城)首开区将于1月6日正式开业。资料显示,港龙城项目于2013年由港龙控股有限公司摘得,2014年起动工,中间经历停工、维权、拍卖,其开业时间也从2

...[详细]

1月4日,观点新媒体了解到,杭州港龙悠乐城原杭州港龙城)首开区将于1月6日正式开业。资料显示,港龙城项目于2013年由港龙控股有限公司摘得,2014年起动工,中间经历停工、维权、拍卖,其开业时间也从2

...[详细]